JoVE 비디오를 활용하시려면 도서관을 통한 기관 구독이 필요합니다. 전체 비디오를 보시려면 로그인하거나 무료 트라이얼을 시작하세요.

Method Article

하이브리드 딥러닝 모델을 사용한 트리파노솜 기생충의 우수한 자동 식별

요약

전 세계 의료용 혈액 기생충은 로우코드 AI 플랫폼에서 간단한 단계를 통해 자동으로 스크리닝되었습니다. 혈액막의 전향적 진단은 하이브리드 딥러닝 모델에서 객체 검출 및 분류 방법을 사용하여 개선되었습니다. 능동적 모니터링과 잘 훈련된 모델의 협업은 트리파노솜 전파의 핫스팟을 식별하는 데 도움이 됩니다.

초록

트리파노소마증은 남아시아와 동남아시아를 포함한 전 세계 여러 지역에서 심각한 공중 보건 문제입니다. 적극적인 감시 하에 있는 핫스팟 지역을 식별하는 것은 질병 전파를 통제하기 위한 기본 절차입니다. 현미경 검사는 일반적으로 사용되는 진단 방법입니다. 그럼에도 불구하고 주로 숙련되고 경험이 풍부한 인력에 의존합니다. 이 문제를 해결하기 위해 사내 로우코드 AI 플랫폼(CiRA CORE)에서 객체 식별 및 객체 분류 신경망 백본의 하이브리드 딥러닝 기술을 활용하는 인공지능(AI) 프로그램을 도입했습니다. 이 프로그램은 원생동물 트리파노솜 종, 즉 Trypanosoma cruzi, T. brucei 및 T. evansi를 오일 침지 현미경 이미지에서 식별하고 분류할 수 있습니다. AI 프로그램은 패턴 인식을 활용하여 단일 혈액 샘플 내에서 여러 원생동물을 관찰 및 분석하고 각 기생충의 핵과 키네토플라스트를 주의 지도를 사용하여 특정 특징으로 강조 표시합니다.

AI 프로그램의 성능을 평가하기 위해 정확도, 재현율, 특이성, 정밀도, F1 점수, 오분류율, ROC(수신기 작동 특성) 곡선 및 정밀도 대 재현율(PR) 곡선과 같은 다양한 통계 측정을 제공하는 두 개의 고유한 모듈이 생성됩니다. 평가 결과에 따르면 AI 알고리즘은 기생충을 식별하고 분류하는 데 효과적입니다. 이 기술은 빠르고 자동화된 정확한 스크리닝 도구를 제공함으로써 질병 감시 및 통제를 혁신할 수 있는 잠재력을 가지고 있습니다. 또한 지역 공무원이 질병 전파 차단 전략에 대해 정보에 입각한 결정을 내리는 데 도움이 될 수 있습니다.

서문

트리파노소마증은 남아시아 및 동남아시아와 같은 아프리카 및 아메리카 대륙 이외의 광범위한 지리적 분포를 가진 인간 질병을 유발하는 다양한 인수공통전염병으로 인해 글로벌 보건 문제에 대한 중요한 도전입니다 1,2,3. 인간 아프리카 트리파노소마증(HAT) 또는 수면병은 트리파노소마 브루세이 감비엔스(Trypanosoma brucei gambiense)와 T. b. 로데시엔스(T. b. rhodesiense)에 의해 발생하며, 각각 만성 및 급성 형태를 나타내며 아프리카에서 주요 확산을 나타냅니다. 원인 기생충은 체체파리의 감염된 타액에 의한 전염으로 인해 살리바리아 그룹에 속한다4. 반면, T. cruzi에 의해 유발된 잘 알려진 미국 트리파노소마증(샤가스병)은 비풍토병 국가의 공중 보건 문제였습니다. 캐나다, 미국, 유럽, 호주, 일본 등 풍토병 지역에서 개인이 자주 이주하기 때문에5. 트리파노솜 감염은 레두비이드(reduviid) 벌레의 감염된 배설물에 의해 전염되기 때문에 Stercoraria 그룹에 속합니다. T. evansi 감염에 의한 트리파노소마제 및 트리파노소마제(Surra disease)는 아프리카, 남미, 서아시아 및 동아시아, 남아시아 및 동남아시아 국가의 풍토병이다 3,6. 트리파노솜에 의한 인간 트리파노소마증이 보고되었지만, 3,4,7,8,9,10,11,12, 기생충 감염의 전파 경로는 논쟁의 여지가 있다: 체체파리, 타바니드 또는 말파리와 같은 혈충을 통한 기계적 또는 감염된 혈액 6,7, 8,9,10,12,13,14입니다. 태국에서는 아직 사례 보고가 발견되지 않았으나, 동부 지역의 개(15), 경주마, 물소에서 T. evansi 감염의 높은 유병률이 발표되었으며16 이는 가축 간의 후천적 전염이 발생했을 가능성을 시사한다. 동물 트리파노솜(T. vivax, T. b. brucei, T. congolense, T. lewisi, T. evansi)에 의한 몇 가지 비정형 인간 감염이 보고되었는데, 이는 인간 트리파노좀의 전형적인 형태가 아니다17. 비정형 인간 감염에 대한 인식이 과소평가될 수 있으며, 이러한 비정형 사례의 검출 및 확인을 위한 개선된 진단 검사 및 현장 조사의 필요성이 강조되고, 전 세계 가축, 식량 안보18 및 인간 건강 관리에 영향을 미치는 동물 병원성 질병의 적절한 통제 및 치료가 가능하다. 이로 인해 능동 감시 중에 외딴 지역의 혈액 샘플을 신속하게 스크리닝하기 위해 기존의 일반적인 방법(현미경 검사)과 통합된 잠재적 전략이 개발되어 질병을 제한하고 통제하기 위한 핫스팟 영역을 식별할 수 있게 되었습니다.

단봉동물, 소, 말, 개 등 다양한 가축에서 산발적으로 발병하여 황소균(T. evansi)을 유발하는 수라병은 인간에게 인수공통감염병일 수 있다 1,4,13,14. 인간 감염은 불가능해 보이는데, 이는 sra-like 유전자에서 발현되는 인간 혈청의 트리파놀리틱 인자가 인간 T. brucei 및 T. congolense를 예방할 수 있기 때문이다 12,19. 더욱이, 인도의 첫 번째 사례 보고에서 알 수 있듯이, 이 질병은 면역력이 저하된 HIV 환자와 관련이 없다4. 상술한 바와 같이, 인체 감염 가능성은 희귀 상염색체 열성 유전 질환인 트리파노솜 용해 인자의 비정상적인 기능을 동반한 고밀도 지단백 결핍, 즉 탕헤르병과 관련이 있을 수 있다4. 2016년 베트남 환자는 2개의 야생형 APOL1 대립유전자와 정상 범위 내의 혈청 APOL1 농도를 가지고 있는 것으로 밝혀졌습니다. 그러나 APOL-1 결핍 이론은 더 이상 유효한 것으로 간주되지 않는다12. 그러므로, 트리파노솜 감염의 가능한 메커니즘 중 하나는 직업적 동물 사육 중 감염된 동물의 혈액과 상처의 직접적인 접촉이다 4,12. 현미경 검사는 T. evansi 형태가 T. brucei 1,12,13의 상대 종과 유사한 우세한 길고 가늘고 편모가 있고 분열하는 트리파노솜을 포함하는 트리포마스티고트의 단형성 형태임을 보여줍니다. 핵은 중앙 위치에 있으며 뒤쪽 위치에 눈에 보이는 작은 키네토플라스트가 있습니다. 이전 연구에 따르면 기생충은 고전적 형태와 잘린 형태로 알려진 두 가지 유사한 형태로 존재할 수 있습니다. 그러나, 숙주(20)에 대한 각각의 병원성 효과를 확인할 필요가 있다. 증상의 경과는 오한과 발한과 관련된 간헐적 발열에 이르기까지 다양합니다. 다행히도 수라민은 중추신경계(CNS)를 침범하지 않는 초기 단계의 인간 아프리카 트리파노소마증에 대한 성공적인 1차 치료제로, 인도와 베트남에서 환자를 치료하고 있다 4,12,21.

임상적 징후 검사를 제외하고, 기생충학적 현미경 관찰 4,9,12, 혈청학적 4,8,9,10,12 및 분자 생물학적 검사 4,12를 포함한 여러 가지 진단 방법이 존재한다. Giemsa로 염색된 얇은 혈액 필름은 현미경 검사에서 존재하는 기생충을 시각화하는 데 자주 사용되며, 이는 일상적이고 일반적으로 사용됩니다22. 그러나 절차는 가능한 것으로 보입니다. 그럼에도 불구하고 시간이 많이 걸리고 노동 집약적이며, 평가자 간 평가 변동성이 있고, 급성 단계에만 민감하며, 개인 교육생이 필요하다23. 분자생물학과 혈청학적 검사 모두 표준화하기 어려운 고가의 장비로 검체를 검사하기 전에 검체를 추출하고 정제하는 등 여러 시료 전처리 과정을 수행하기 위해 고도로 숙련된 인력이 필요했는데, 이는 표준화가 어렵고, 기생충 외 물질로 인한 오염 위험, 결과의 불일치24. 위에서 설명한 근거에 기초하여, 현장 감시 연구를 지원하고 질병 전파를 추가로 통제할 수 있는 핫스팟 영역을 식별하기 위해 조사 결과가 적시에 보고되도록 하기 위해 신속 및 조기 스크리닝 기술이 필요하다 1,8. 전산화 기반 장치(CAD)는 조직병리학 및 세포병리학적 작업을 포함한 의료 분야의 혁신 기술로 제안되어 왔다25. 위에서 언급한 CAD는 패턴 인식, 즉 인공 지능(AI)을 사용하여 고속으로 수행되고 계산되었습니다. AI 방법은 많은 수의 데이터 세트 샘플을 처리하는 데 사용할 수 있는 컨볼루션 신경망 알고리즘, 특히 데이터 소비 시 잘 훈련된 모델을 훈련하는 지도 학습 접근 방식을 사용하여 수행됩니다.

일반적으로 AI는 데이터 레이블링과 같이 전문적인 인텔리전스가 필요한 작업을 해결하는 컴퓨터의 능력입니다. AI의 하위 분야인 기계 학습(ML)은 특징 추출과 패턴 인식으로 구성된 두 가지 프로세스를 가진 컴퓨터 시스템으로 표현됩니다. 딥러닝(Deep Learning, DL) 또는 고급 ML 알고리즘은 인간과 유사한 성능을 인간 전문가가 달성한 것과 동일한 정확도 수준과 비교하는 컴퓨터화된 프로그램 및 장치의 개발을 말한다26. 현재 의학 및 수의학 분야에서 DL의 역할은 최근 예방을 목표로 전염병 예방을 유망하게 확대하고 혁신하고 있으며 개별 의료진에게 안내하고 있습니다22,27. 잠재적인 DL 애플리케이션은 품질 라벨과 많은 수의 증강 데이터 세트로 무궁무진하여 전문가가 프로젝트 작업을 관리할 수 있도록 합니다. 특히, 컴퓨터 보조 분석과 함께 디지털 이미지의 발전은 보고된 병리학의 5가지 범주에서 자동 진단 및 스크리닝을 개선했습니다. 정적, 동적, 로봇적, 전체 슬라이드 이미징 및 하이브리드 방법 포함28. DL 알고리즘 접근 방식과 디지털 이미지 데이터의 통합은 현지 직원이 일상 업무에서 기술을 활용하도록 장려할 수 있다는 점을 고려할 필요가 있습니다.

이전에는 하이브리드 모델을 사용하는 예측 정확도의 증가가 입증되었습니다27. 현미경 이미지에서 트리파노솜 기생충을 식별하기 위해 이 연구에서는 YOLOv4-tiny (객체 감지) 및 Densenet201 (객체 분류) 알고리즘을 통합한 두 가지 하이브리드 모델을 제시합니다. 여러 검출 모델 중에서, CSPDarknet53 백본을 갖는 YOLOv4-tiny 모델은 국소화 및 분류 측면에서 예측 결과로서 높은 성능을 보였다29. 실시간 검출기는 입력 네트워크 해상도, 컨벌루션 계층의 양, 전체 파라미터 및 계층 출력 개수 간의 최적 균형을 수정했기 때문에 이전 버전과 비교할 때 빠른 작동 속도의 우선 순위를 지정하고 병렬 계산을 최적화하는 것이 개선되었습니다. DenseNet(Dense Convolutional Network)은 경쟁 데이터 세트에서 최첨단 결과를 달성하는 또 다른 인기 있는 모델입니다. DenseNet201은 ResNet101과 유사한 유효성 검사 오류를 생성했습니다. 그러나 DenseNet201의 매개변수는 2천만 개 미만이며, 이는 ResNet101의 4천만 개 이상의 매개변수30보다 적습니다. 따라서 DenseNet 모델은 과적합의 징후 없이 증가하는 매개변수 수로 예측 정확도를 향상시킬 수 있습니다. 여기서 인공 지능(AI) 프로그램은 사내 CiRA CORE 플랫폼에서 심층 탐지 및 분류 신경망 백본과 함께 하이브리드 딥 러닝 알고리즘을 활용합니다. 개발된 프로그램은 원생동물 트리파노솜 종, 즉 Trypanosoma cruzi, T. brucei 및 T. evansi를 오일 침지 현미경 이미지에서 식별하고 분류할 수 있습니다. 이 기술은 빠르고 자동화된 정확한 스크리닝 방법을 제공하여 질병 감시 및 통제에 혁명을 일으킬 수 있는 잠재력을 가지고 있습니다. 현지 직원이 기생충 원생동물 질병에 대한 전염 차단 전략에 대해 정보에 입각한 결정을 내리는 데 도움이 될 수 있습니다.

프로토콜

보관된 혈액 필름 및 프로젝트 설계는 기관 생물 안전 위원회, 수의학 학부의 기관 동물 관리 및 사용 위원회, 출라롱콘 대학교(IBC No. 2031033 및 IACUC No. 1931027) 및 King Mongkut's Institute of Technology Ladkrabang (EC-KMITL_66_014)의 인간 연구 윤리 위원회의 승인을 받았습니다.

1. RAW 이미지 준비

- 이미지 데이터 세트 준비

- 기생충학자 전문가들이 확인한 T. brucei, T. cruzi 및 T. evansi를 포함하여 혈액 기생충 감염이 있는 최소 13개의 양성 슬라이드를 얻습니다. 교육용(10개 슬라이드)과 테스트용(3개 슬라이드)을 위한 13개의 슬라이드를 분리합니다.

- 디지털 카메라가 장착된 광학 현미경의 오일 이멀젼 필드에서 위에서 설명한 Giemsa 염색 박막 혈액 필름의 이미지를 획득합니다. 현미경 검사에서 세 가지 기생충 종 모두의 trypomastigotes의 여러 물체를 포함하는 이미지를 얻습니다. 가느다란 모양, 긴 꼬리, 물결 모양의 막, 앞쪽 끝의 키네토플라스트(kinetoplast)를 찾으십시오.

참고: 두꺼운 도말과 얇은 도말을 모두 생성하면 급성기 트리파노소마증의 검출이 향상될 것이다31. 손가락 찌르기에 의한 채혈은 WHO32에서 권장하고 있습니다. 그럼에도 불구하고, 박막은 트리파노소마 크루지(Trypanosoma cruzi ) 및 다른 종들을 식별하는데 더 효과적인데, 이는 이들 유기체들이 두꺼운 막에서 왜곡되는 경향이 있기 때문이다(33). 이에 비추어 우리는 이 연구를 위해 기생충의 적절한 형태를 유지하기 위해 얇은 혈액막 이미지를 활용했습니다. - 모든 이미지는 1,600 x 1,200픽셀, 24비트 심도 및 JPG 파일 형식 사양의 기생충 관련 폴더에 저장합니다. 영상을 ~6:1 비율로 훈련 세트와 테스트 세트로 분할합니다.

참고: https://gitlab.com/parasite3/superior-auto-identification-of-medically-important-trypanosome-parasites-by-using-a-hybrid-deep-learning-model/-/blob/main/JOVEimage.zip 참조; 650개의 이미지를 분할하여 모델을 학습(560개) 및 테스트(90개)했습니다. - 관심 영역을 두 클래스, 즉 트리파노솜과 비트리파노솜에 대한 사각형 레이블로 정의합니다. 자동 자르기 모듈을 사용하여 잘 학습된 개체 감지 모델을 사용하여 감지된 모든 이미지를 자릅니다. 자동 자르기 모듈은 사내 CiRA CORE 프로그램에서 개발된 모듈입니다( 재료 표 참조). 개체 분류를 학습하기 위해 이미지당 단일 개체를 수집합니다.

참고: 이 문서에서는 학습(892개 이미지) 및 테스트(126개 이미지)를 위해 1,017개의 이미지를 분할했습니다. 모델 학습은 leukocyte, T. brucei, T. cruzi 및 T. evansi를 포함한 4개의 표지된 클래스로 수행되었습니다.

2. 사내 CiRA CORE 플랫폼을 통한 교육 과정

- 새 프로젝트 시작

- 컴퓨터 바탕 화면에서 CiRA CORE 응용 프로그램을 열고( 자료 표 참조) 프로그램 아이콘을 두 번 클릭하여 새 프로젝트를 만듭니다.

- 왼쪽 수직 도구 모음에서 작업 아이콘을 선택하여 필요한 도구를 선택합니다.

- 개체 감지 모델 학습

- 끌어서 놓기 방법을 사용하여 데이터 레이블링 및 훈련을 위한 training-DL 모델 함수를 선택합니다. 일반 도구 모음 | 시라 AI | 드래그 딥트레인(Drag DeepTrain) | 화면(오른쪽)에 DeepTrain을 놓습니다.

참고: 추가 옵션의 경우 선택한 도구를 마우스 오른쪽 버튼으로 클릭하고 적절한 기능( 복사, 잘라내기 또는 삭제)을 수행합니다. - DeepTrain 도구의 설정을 사용하여 이미지를 가져옵니다. 이미지 로드 버튼을 클릭하고 이미지 디렉토리로 이동합니다. 마우스 왼쪽 버튼을 클릭한 상태에서 선택한 객체의 이름을 지정하여 객체에 레이블을 지정합니다. 디스플레이 설정 버튼을 클릭하여 사각형 선 두께와 글꼴 크기를 조정하고 동일한 디렉토리에 GT를 .gt 파일로 저장합니다.

알림: 전원 부족, 자동 프로그램 종료 및 라벨링 프로세스 내에서 중단과 같은 원치 않는 조건을 피하기 위해 필요에 따라 저장하십시오. - 모델 훈련에 앞서 네 가지 증대 기법( 회전, 대비, 노이즈 및 흐림)을 사용하여 충분한 정보를 수집하도록 데이터를 확장합니다. Gen Setting 버튼을 클릭하여 이 기능에 액세스합니다.

- DeepTrain 도구에서 Training(훈련) 버튼을 클릭하여 모델 훈련을 시작합니다. 학습 부분에는 학습 파일 생성 및 학습이라는 두 가지 하위 기능이 있습니다. 학습 파일 생성 기능에서 원하는 모델, 배치 크기, 세분화를 선택합니다. Generate(생성) 버튼을 클릭하여 데이터를 생성하고 디렉토리에 저장합니다. 훈련 함수에서 i) 조건 및 백업을 위해 생성된 다른 훈련 위치를 사용하거나, ii) 지속적인 훈련을 위해 미리 빌드된 가중치를 사용하거나, iii) 현재 훈련 설계에 대한 파라미터를 재정의하는 옵션을 선택합니다. 이렇게 하면 모델 구성 및 학습 조건이 설계됩니다.

참고: 생성 프로세스 시간은 이미지 파일 크기, 보강 사용량 및 사용 가능한 메모리 공간에 따라 다릅니다. - 필요한 모든 구성이 완료되면 학습 단추를 클릭하여 모델 학습을 시작합니다. 프로그램이 지속적으로 실행되도록 하여 훈련 과정에서 훈련 손실을 평가하고 데이터 세트의 가중치를 조정합니다. 모델이 최적의 손실에 도달하면 Export 버튼을 클릭하여 훈련된 가중치 파일을 지정된 디렉터리에 저장합니다.

- 끌어서 놓기 방법을 사용하여 데이터 레이블링 및 훈련을 위한 training-DL 모델 함수를 선택합니다. 일반 도구 모음 | 시라 AI | 드래그 딥트레인(Drag DeepTrain) | 화면(오른쪽)에 DeepTrain을 놓습니다.

3. 객체 검출 모델 평가

- 드래그 앤 드롭 방식을 이용한 모델 평가를 위한 객체 검출 모델 평가 기능을 선택합니다. 플러그인 툴바 | 평가 | 드래그 EvalDetect | 화면(오른쪽)에 EvalDetect를 놓습니다.

- Setting( 설정 )을 클릭하고 Detection(감지), Evaluate(평가) 및 Plot(플롯)의 세 가지 기능을 기다립니다. Load Config를 클릭하여 디렉터리(2.2.5단계)에서 훈련된 가중치 파일을 가져와서 모델 평가를 시작합니다.

- 탐지 기능에서 NMS(Non-Maximum Suppression) 값을 선택하여 중복 오탐(FP) 탐지를 제거하여 정확도를 높입니다. NMS는 안정성 향상을 위해 중복 모델 생성 탐지를 제거합니다.

- 평가 기능에서 다음 단계를 진행합니다.

- Browse(찾아보기)를 클릭하여 이미지 파일 디렉터리에서 테스트 이미지를 가져옵니다. GT 로드를 클릭하여 2.2.2단계에서 저장된 디렉토리에서 GT 파일을 가져옵니다.

- IoU(Intersection over Union) 값을 선택하여 특정 이미지 테스트 데이터 세트에 대한 정확도를 평가합니다.

- Evaluation( 평가 ) 버튼을 클릭하여 지정된 디렉터리에서 검색 모델을 평가합니다. 평가가 완료되면 결과가 클래스 이름별로 정렬된 동일한 디렉토리에 CSV 파일로 자동 저장됩니다. 이 CSV 파일은 각 클래스에 대해 TP(True Positive), FP(False Positive), FN(False Negative), Recall, Precision 과 같은 필수 매개변수를 제공합니다.

- 정밀도-재현율(PR) 곡선을 플롯하려면 플롯 함수에서 다음 단계를 수행합니다. 찾아보기를 클릭하여 이전 섹션(3.4단계) 디렉토리에서 CSV 파일을 가져옵니다. 목록에서 클래스를 선택하고 플롯 버튼을 클릭하여 편집 가능한 PR 곡선 이미지를 표시합니다.

- 마지막으로 PR 곡선의 AUC 값이 있는 이미지를 지정된 디렉토리에 필요한 이미지 형식으로 저장하려면 이미지의 저장 버튼을 클릭합니다.

4. 이미지당 단일 개체에 대한 이미지 자르기

- 이미지를 자르기 전에 다음 단계를 완료하십시오.

- 이미지 슬라이드 도구의 설정에 액세스하여 이미지 파일 디렉토리에서 이미지를 가져옵니다.

- 훈련된 가중치 가져오기 file (2.2.8단계에서 저장됨) Deep Detect 도구의 설정에 액세스하여. Config(구성 ) 버튼을 클릭합니다 . + 버튼을 누르고 백엔드 (CUDA 또는 CPU)를 선택하고 이름을 입력한 다음 OK를 클릭하고 가중치 파일 디렉토리를 선택한 다음 Choose를 클릭합니다. Deep Detect 도구 내에서 검출 매개변수(임계값 및 비최대값 억제 (nms))를 선택합니다. 드로잉 매개변수; 추적 매개변수; 및 관심 영역(ROI) 매개변수.

- Deep Crop 도구의 설정에 액세스하여 자른 이미지를 저장할 디렉토리를 선택합니다. 찾아보기 클릭 | 자른 이미지를 저장할 디렉토리 선택 | 선택 | 이미지 형식 선택(JPG 또는 PNG) | 자동 저장 옵션을 활성화합니다.

- 이미지를 분류하고 분할하기 위해 이미지당 하나의 객체를 얻기 위해 이미지를 자릅니다. 이 프로세스를 수행하려면 네 가지 도구를 활용하고 도구 간의 연결을 설정하십시오. 일반 도구 모음 | 일반 | 버튼 실행. 그런 다음 General( 일반) 도구 모음 | 시라 AI | 딥디텍트; 그런 다음 일반 도구 모음 | 시라 AI | 딥크롭(DeepCrop). 마지막으로 Image toolbar | 획득 | 이미지슬라이드.

- 필요한 모든 설정이 완료되면 버튼 실행 도구를 클릭하여 이미지 자르기 프로세스를 시작합니다.

- 크기가 608 x 608인 단일 객체 이미지로 구성된 새 이미지 훈련 데이터 세트를 가져옵니다.

5. 모델 학습으로서의 이미지 분류

- 드래그 앤 드롭을 사용하여 데이터 학습을 위한 이미지 분류 모델 학습 함수를 선택합니다. 이미지 툴바 | 딥클래시프 | 드래그 ClassifTrain | ClassifTrain을 화면에 놓습니다.

- ClassifTrain 도구의 설정을 사용하여 모델 학습을 위한 이미지를 가져옵니다. 폴더 열기 버튼을 클릭하고 원하는 이미지 디렉토리로 이동합니다. 훈련하기 전에 Augmentation 버튼을 클릭하여 Rotation, Contrast, Flipping(수평 및/또는 수직), Noise 및 Blur와 같은 기술을 사용하여 자세한 정보를 확장합니다.

- 모델 학습을 시작하려면 ClassifTrain 도구의 GenTrain 버튼을 클릭합니다. GenTrain 함수에서 모델, 배치 크기, 세분화를 선택합니다. 생성된 파일을 저장할 디렉토리를 지정합니다. Generate(생성) 버튼을 클릭하여 학습용 데이터를 진행합니다. Train 함수에서 적절한 옵션(기본 가중치 또는 사용자 지정 가중치로 훈련 계속)을 선택합니다.

참고: 생성 프로세스는 이미지 파일 크기, 증강 사용, 클래스 밸런싱 및 사용 가능한 메모리 공간과 같은 요인에 따라 시간이 걸릴 수 있습니다. - 모든 준비가 완료되면 시작 단추를 클릭하여 모델 학습을 시작합니다. 프로그램이 지속적으로 실행되도록 하여 훈련 과정에서 훈련 손실을 평가하고 데이터 세트의 가중치를 조정합니다. 모델이 원하는 수준의 손실에 도달하면 Export 버튼을 클릭하여 훈련된 가중치 파일을 지정된 디렉터리에 저장합니다.

6. 분류 모델 평가

- 드래그 앤 드롭 방식으로 모델 평가를 위한 이미지 분류 모델 평가 기능을 선택합니다. 플러그인 툴바 | 평가 | 드래그 EvaluateClassif | 화면(오른쪽)에 EvaluateClassif를 놓습니다.

- EvaluateClassif 도구 내의 추가 기능, 즉 Evaluate 및 PlotROC에 액세스하려면 설정을 클릭하십시오.

- 모델 평가를 시작하려면 EvaluateClassif 도구에서 평가 버튼을 클릭합니다. 평가 기능에서 다음 단계를 수행합니다.

- Load folder image(로드 폴더 이미지)를 클릭하여 이미지 파일 디렉터리에서 테스트 이미지를 가져옵니다. Load Config를 클릭하여 디렉토리(5.4단계에서 저장)에서 훈련된 가중치 파일을 가져옵니다. 시작 버튼을 클릭하여 분류 모델을 평가합니다.

- 평가가 완료되면 CSV로 내보내기 버튼을 클릭하여 평가된 파일을 지정된 디렉터리에 CSV로 저장합니다. 모든 임계값에서 데이터를 평가하려면 모든 임계값 시작을 클릭하여 지정된 디렉터리에 클래스 이름과 함께 CSV 파일을 저장합니다. 저장된 CSV 파일에는 각 클래스에 대한 재현율 (True Positive Rate), False Positive Rate, Precision 과 같은 파라미터가 포함되어 있습니다.

- ROC(Receiver Operating Characteristics) 곡선을 플로팅하려면 EvaluateClassif 툴 내에서 PlotROC 버튼을 클릭하십시오. PlotROC 함수에서 다음 단계를 수행합니다.

- 찾아보기를 클릭하여 이전에 얻은 디렉토리에서 CSV 파일을 가져옵니다. 가져온 클래스 목록을 검사하고 각 클래스 레이블을 선택하여 ROC 곡선을 플로팅합니다.

- 플롯 버튼을 클릭하여 ROC 곡선을 이미지로 시각화합니다. 원하는 대로 편집하여 글꼴 크기, 글꼴 색상, 소수점 반올림, 선 스타일 및 선 색상을 포함한 이미지 속성을 조정합니다.

- 마지막으로 저장 버튼을 클릭하여 지정된 디렉토리에 필요한 이미지 형식으로 AUC 값이 있는 ROC 곡선 이미지를 저장합니다.

7. CiRA CORE 애플리케이션으로 프로세스 테스트

- 모델 테스트로서의 객체 감지

- 모델 테스트를 수행하려면 네 가지 도구를 활용하고 도구 간의 연결을 설정합니다. 일반 도구 모음 | 일반 | 버튼 실행. 그런 다음 일반 도구 모음 | 일반 | 디버그. 그런 다음 일반 도구 모음 | 시라 AI | DeepDetect, 마지막으로 이미지 도구 모음 | 획득 | 이미지슬라이드.

- 이미지를 테스트하기 전에 다음 단계를 수행합니다.

- 이미지 슬라이드 도구에서 설정 옵션을 클릭하여 이미지 파일 디렉토리에서 테스트 이미지를 가져옵니다.

- DeepDetect 도구에서 Setting 옵션을 클릭하여 2.2.8단계에서 저장된 훈련된 가중치 파일을 가져옵니다. Config 버튼을 클릭한 다음 + 버튼을 클릭하고 백엔드(CUDA 또는 CPU)를 선택하고 이름을 입력한 다음 OK를 클릭하고 가중치 파일 디렉토리를 선택한 다음 Choose를 클릭합니다. DeepDetect 툴에서 검출 파라미터(임계값 및 nms), 드로잉 파라미터, 추적 파라미터 및 ROI 파라미터를 선택합니다.

- 디버그 도구에서 이미지 함수를 클릭하여 테스트 이미지 결과를 확인합니다.

- 마지막으로 버튼 실행 도구에서 실행 버튼을 클릭하여 각 이미지에 대한 예상 결과를 확인합니다.

- 모델 테스트로서의 이미지 분류

- 모델 테스트를 수행하려면 네 가지 도구를 활용하고 도구 간의 연결을 설정합니다. 일반 도구 모음 | 일반 | 버튼 실행; 그런 다음 일반 도구 모음 | 디버그. 그런 다음 Image toolbar | 획득 | ImageSlide, 마지막으로 이미지 도구 모음 | 딥클래시프 | DeepClassif입니다.

- 이미지를 테스트하기 전에 다음 단계를 수행합니다.

- 이미지 슬라이드 도구에서 설정 옵션을 클릭하여 이미지 파일 디렉토리에서 테스트 이미지를 가져옵니다.

- 섹션 5.5에서 저장된 훈련된 가중치 파일을 DeepClassif 도구에서 Setting 옵션을 클릭하여 가져옵니다. Config 버튼을 클릭합니다 | + 버튼 | 백엔드 선택(CUDA 또는 CPU) | 이름 제공 | 딸깍 하는 소리 OK | 가중치 파일 디렉토리 | 선택을 클릭합니다. DeepClassif 툴에서 분류 파라미터(임계값 및 최상위 예측 개수), 가이드 맵 파라미터(임계값, 알파, 베타, 컬러맵) 및 컬러맵의 다양한 파라미터를 선택합니다.

- 디버그 도구에서 이미지 함수를 클릭하여 테스트 이미지 결과를 확인합니다.

- 마지막으로 버튼 실행 도구에서 실행 버튼을 클릭하여 각 이미지에 대한 예상 결과를 확인합니다.

8. 모델 테스트로서의 하이브리드(탐지 및 분류)

- 이 모델 테스트를 수행하려면 네 가지 도구를 사용하고 도구 간의 연결을 설정합니다. 일반 도구 모음 | 일반 | 버튼런. 그런 다음 일반 도구 모음 | 일반 | 디버그. 그런 다음 이미지 도구 모음 | 획득 | ImageSlide, 마지막으로 이미지 도구 모음 | 딥컴포지트 | 딥D->C.

- 이미지를 테스트하기 전에 다음 단계를 수행합니다. 이미지 슬라이드 도구에서 설정 옵션을 클릭하여 이미지 파일 디렉토리에서 테스트 이미지를 가져옵니다. 섹션 2.1.5 및 섹션 4.4에서 저장된 두 개의 훈련된 가중치 파일을 DeepD->C 도구에서 설정 옵션을 클릭하여 가져옵니다.

- 감지 기능의 경우 구성 버튼 |+ 버튼을 클릭하고 백엔드(CUDA 또는 CPU) | 이름 제공 | OK(확인)를 클릭합니다. | 가중치 파일 디렉토리 선택 | 선택을 클릭합니다. Detect 함수에서 검출 파라미터(Threshold 및 nms), 드로잉 파라미터, 추적 파라미터 및 ROI 파라미터를 선택합니다.

- Classif 기능의 경우 구성 버튼 |+ 버튼을 클릭하고 백엔드(CUDA 또는 CPU) | 이름 제공 | 확인(OK) | 가중치 파일 디렉토리 선택 | 선택(Choose)을 클릭합니다. Classif 함수에서 분류 파라미터(임계값 및 최상위 예측 개수)와 가이드 맵 파라미터(임계값, 알파, 베타, 컬러맵)를 선택합니다.

- 디버그 도구에서 이미지 함수를 클릭하여 테스트 이미지 결과를 확인합니다. 마지막으로 버튼 실행 도구에서 실행 버튼을 클릭하여 각 이미지에 대한 예상 결과를 확인합니다.

9. 5중 교차 검증

참고: 제안된 모델의 성능을 보다 효과적으로 검증하기 위해 K-폴드 교차 검증이 사용됩니다.

- 데이터 세트를 교차 검증의 5개 겹에 해당하는 5개의 섹션으로 나눕니다. 모델 훈련 및 테스트를 반복할 때마다 한 섹션을 테스트용 검증 세트로 사용하고 나머지 4개 섹션을 훈련용으로 사용합니다. 이 과정을 다섯 번 반복하되 각 접기가 한 번씩 검증 세트로 사용됩니다.

- 접기 1-5의 경우:

- 섹션 5를 반복하여 네 겹의 학습 데이터를 사용하여 모델을 학습합니다.

- 섹션 7.2를 반복하여 나머지 접기를 테스트 세트로 사용하여 모델을 테스트합니다.

10. 모델 평가

- 혼동행렬

- 테스트 결과에 따라 네 가지 조건이 다음과 같이 발생합니다.

- 참 긍정(TP): 입력 이미지가 참이고 예측도 참인 경우.

- 거짓 긍정(FP): 입력 이미지가 거짓이지만 예측이 참인 경우.

- 거짓 부정(FN): 입력 이미지가 참이지만 예측이 거짓인 경우.

- 참 부정(TN): 입력 이미지가 false이고 예측도 false인 경우입니다.

- 이 네 가지 조건을 사용하여 혼동행렬로 성능을 평가합니다.

- 테스트 결과에 따라 네 가지 조건이 다음과 같이 발생합니다.

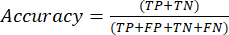

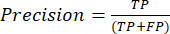

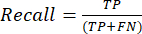

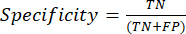

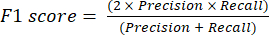

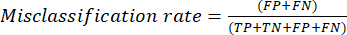

- 성능 평가

- 가장 일반적으로 사용되는 분류 성능 메트릭은 정확도, 정밀도, 재현율, 특이성 및 F1 점수 값입니다. 혼동 행렬의 값에서 모델 성능을 평가하는 데 사용되는 방정식 (1-6)의 모든 평가 메트릭을 계산합니다.

(1)

(1) (2)

(2) (3)

(3) (4)

(4) (5)

(5) (6)

(6)

- 가장 일반적으로 사용되는 분류 성능 메트릭은 정확도, 정밀도, 재현율, 특이성 및 F1 점수 값입니다. 혼동 행렬의 값에서 모델 성능을 평가하는 데 사용되는 방정식 (1-6)의 모든 평가 메트릭을 계산합니다.

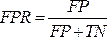

- ROC 곡선

참고: ROC 곡선 은 임계값 설정이 다른 분류 문제에 대한 성능 측정값입니다. ROC 곡선 아래 면적(AUC)은 분리성의 정도 또는 측정값을 나타내고 ROC 는 확률 곡선입니다.- ROC 곡선은 T축과 X축에 각각 TPR(진양성률)과 FPR(거짓양성률) 값이 표시된 2차원 그래프입니다. 혼동행렬에서 얻은 TPR 및 TFR 값을 사용하여 ROC 곡선을 생성합니다. TPR 값은 감도와 동일합니다. 수학식 7을 사용하여 FPR 값을 계산합니다.

(7)

(7) - TPR 및 FPR 값을 얻은 후 Python 환경에서 Jupyter Notebook 오픈 소스 웹 도구를 사용하여 ROC 곡선을 플로팅합니다. AUC는 ROC 곡선 분석에서 제안된 모델의 성능을 평가하는 효과적인 방법입니다.

- ROC 곡선은 T축과 X축에 각각 TPR(진양성률)과 FPR(거짓양성률) 값이 표시된 2차원 그래프입니다. 혼동행렬에서 얻은 TPR 및 TFR 값을 사용하여 ROC 곡선을 생성합니다. TPR 값은 감도와 동일합니다. 수학식 7을 사용하여 FPR 값을 계산합니다.

- PR 곡선

- PR 곡선을 사용하여 PR 곡선 아래 면적을 측정하여 모델을 평가합니다. 모델의 정밀도를 플로팅하여 PR 곡선을 구성하고 모델의 신뢰 임계값 함수를 사용하여 재현율을 생성합니다. PR 곡선도 2차원 그래프이므로 x축에 재현율을 플로팅하고 y축에 정밀도를 플로팅합니다.

- Python 환경에서 오픈 소스 Jupyter Notebook 웹 도구를 사용하여 ROC 곡선과 같은 PR 곡선을 그립니다. AUC(Precision-Recall curve) 점수 아래 영역도 다중 레이블 분류에 유용합니다.

결과

이 연구에서는 트리파노솜 기생충 감염이 있는 혈액 샘플의 양성을 자동으로 예측하는 데 도움이 되는 하이브리드 딥 러닝 알고리즘이 제안되었습니다. 보관된 Giemsa로 염색된 혈액 필름은 다크넷 백본 신경망을 기반으로 하는 물체 감지 알고리즘을 사용하여 기생하는 것과 기생하지 않는 것을 현지화하고 분류하기 위해 분류되었습니다. 이전 모델에서 얻은 직사각형 상자 예측 결과 내에서 T....

토론

트리파노소마 원생동물 감염에 대한 현미경 관찰은 특히 숙련된 기술자가 부족하고 노동 집약적이고 시간이 많이 소요되는 외딴 지역의 감시 중에 조기에 일반적으로 사용되며, 이는 모두 보건 기관에 적시에 보고하는 데 장애가 됩니다. 면역학 및 중합효소연쇄반응(PCR)과 같은 분자생물학 기법이 실험실 결과의 효과를 뒷받침하는 고감도 방법으로 승인되었지만, 이를 처리하기 위해서는 고가의...

공개

모든 저자는 재정 공개와 이해 상충이 없습니다.

감사의 말

이 작품(신학자 연구비, 연구비 지원금, 연구비 지원금. RGNS 65 - 212)는 고등교육과학연구혁신부(OPS MHESI), 태국 과학연구혁신부(TSRI) 및 King Mongkut's Institute of Technology Ladkrabang의 재정 지원을 받았습니다. 연구 프로젝트에 자금을 지원해 주신 태국 국립연구위원회(NRCT)[NRCT5-RSA63001-10]에 감사드립니다. M.K.는 태국 과학 연구 및 혁신 기금 출라롱콘 대학교(Chulalongkorn University)의 지원을 받았습니다. 또한 연구 프로젝트를 지원하기 위해 딥 러닝 플랫폼과 소프트웨어를 제공한 College of Advanced Manufacturing Innovation, King Mongkut's Institute of Technology, Ladkrabang에도 감사드립니다.

자료

| Name | Company | Catalog Number | Comments |

| Darknet19, Darknet53 and Densenet201 | Gao Huang, Z. L., Laurens van der Maaten. Densely Connected Convolutional Networks. arXiv:1608.06993 [cs.CV]. (2016) | https://github.com/liuzhuang13/DenseNet | Deep convolutional neural network model that can function to classification Generic name: YOLO model/ detection model? |

| Olympus CX31 Model CX31RRBSFA | Olympus, Tokyo, Japan | SN 4G42178 | A light microscope |

| Olympus DP21-SAL U-TV0.5XC-3 | Olympus, Tokyo, Japan | SN 3D03838 | A digital camera Generic name: Classification models/ densely CNNs |

| Window 10 | Microsoft | Window 10 | Operation system in computers |

| YOLO v4-tiny | Naing, K. M. et al. Automatic recognition of parasitic products in stool examination using object detection approach. PeerJ Comput Sci. 8 e1065, (2022). | https://git.cira-lab.com/users/sign_in | Deep convolutional neural network model that can function to both localization and also classification |

| https://git.cira-lab.com/users/sign_in |

참고문헌

- Kasozi, K. I., et al. Epidemiology of trypanosomiasis in wildlife-implications for humans at the wildlife interface in Africa. Frontiers in Veterinary Science. 8, 621699 (2021).

- Ola-Fadunsin, S. D., Gimba, F. I., Abdullah, D. A., Abdullah, F. J. F., Sani, R. A. Molecular prevalence and epidemiology of Trypanosoma evansi among cattle in peninsular Malaysia. Acta Parasitologica. 65 (1), 165-173 (2020).

- Aregawi, W. G., Agga, G. E., Abdi, R. D., Buscher, P. Systematic review and meta-analysis on the global distribution, host range, and prevalence of Trypanosoma evansi. Parasites & Vectors. 12 (1), 67 (2019).

- Joshi, P. P., et al. Human trypanosomiasis caused by Trypanosoma evansi in India: the first case report. The Am Journal of Tropical Medicine and Hygiene. 73 (3), 491-495 (2005).

- Lidani, K. C. F., et al. Chagas disease: from discovery to a worldwide health problem. Frontiers in Public Health. 7, 166 (2019).

- Sazmand, A., Desquesnes, M., Otranto, D. Trypanosoma evansi. Trends in Parasitology. 38 (6), 489-490 (2022).

- Powar, R. M., et al. A rare case of human trypanosomiasis caused by Trypanosoma evansi.Indian. Journal of Medical Microbiology. 24 (1), 72-74 (2006).

- Shegokar, V. R., et al. Short report: Human trypanosomiasis caused by Trypanosoma evansi in a village in India: preliminary serologic survey of the local population. American Journal of Tropical Medicine and Hygiene. 75 (5), 869-870 (2006).

- Haridy, F. M., El-Metwally, M. T., Khalil, H. H., Morsy, T. A. Trypanosoma evansi in dromedary camel: with a case report of zoonosis in greater Cairo, Egypt. Journal of the Egyptian Society of Parasitology. 41 (1), 65-76 (2011).

- Dey, S. K. CATT/T.evansi antibody levels in patients suffering from pyrexia of unknown origin in a tertiary care hospital in Kolkata. Research Journal of Pharmaceutical, Biological and Chemical Sciences. 5, 334-338 (2014).

- Dakshinkar, N. P., et al. Aberrant trypanosomias in human. Royal Veterinary Journal of India. 3 (1), 6-7 (2007).

- Vn Vinh Chau, N., et al. A clinical and epidemiological investigation of the first reported human infection with the zoonotic parasite Trypanosoma evansi in Southeast Asia. Clinical Infectious Diseases. 62 (8), 1002-1008 (2016).

- Misra, K. K., Roy, S., Choudhary, A. Biology of Trypanosoma (Trypanozoon) evansi in experimental heterologous mammalian hosts. Journal of Parasitic Diseases. 40 (3), 1047-1061 (2016).

- Nakayima, J., et al. Molecular epidemiological studies on animal trypanosomiases in Ghana. Parasites & Vectors. 5, 217 (2012).

- Riana, E., et al. The occurrence of Trypanosoma in bats from Western Thailand. The 20th Chulalongkorn University Veterinary Conference CUVC 2021: Research in practice. 51, (2021).

- Camoin, M., et al. The Indirect ELISA Trypanosoma evansi in equids: optimisation and application to a serological survey including racing horses, in Thailand. BioMed Research International. 2019, 2964639 (2019).

- Truc, P., et al. Atypical human infections by animal trypanosomes. PLoS Neglected Tropical Diseases. 7 (9), 2256 (2013).

- Desquesnes, M., et al. Diagnosis of animal trypanosomoses: proper use of current tools and future prospects. Parasites & Vectors. 15 (1), 235 (2022).

- Da Silva, A. S., et al. Trypanocidal activity of human plasma on Trypanosoma evansi in mice. Revista Brasileira de Parasitologia Veterinaria. 21 (1), 55-59 (2012).

- Desquesnes, M., et al. Trypanosoma evansi and surra: a review and perspectives on transmission, epidemiology and control, impact, and zoonotic aspects. BioMed Research International. 2013, 321237 (2013).

- World Health Organization. A new form of human trypanosomiasis in India. Description of the first human case in the world caused by Trypanosoma evansi. Weekly Epidemiological Record. 80 (7), 62-63 (2005).

- Naing, K. M., et al. Automatic recognition of parasitic products in stool examination using object detection approach. PeerJ Computer Science. 8, 1065 (2022).

- Wongsrichanalai, C., Barcus, M. J., Muth, S., Sutamihardja, A., Wernsdorfer, W. H. A review of malaria diagnostic tools: microscopy and rapid diagnostic test (RDT). American Journal of Tropical Medicine and Hygiene. 77, 119-127 (2007).

- Rostami, A., Karanis, P., Fallahi, S. Advances in serological, imaging techniques and molecular diagnosis of Toxoplasma gondii infection. Infection. 46 (3), 303-315 (2018).

- Ahmad, Z., Rahim, S., Zubair, M., Abdul-Ghafar, J. Artificial intelligence (AI) in medicine, current applications and future role with special emphasis on its potential and promise in pathology: present and future impact, obstacles including costs and acceptance among pathologists, practical and philosophical considerations. A comprehensive review. Diagnostic Pathology. 16 (1), 24 (2021).

- Sarker, I. H. Deep learning: a comprehensive overview on techniques, taxonomy, applications and research directions. SN Computer Science. 2 (6), 420 (2021).

- Kittichai, V., et al. Classification for avian malaria parasite Plasmodium gallinaceum blood stages by using deep convolutional neural networks. Scientific Reports. 11 (1), 16919 (2021).

- Baskota, S. U., Wiley, C., Pantanowitz, L. The next generation robotic microscopy for intraoperative teleneuropathology consultation. Journal of Pathology Informatics. 11, 13 (2020).

- Bochkovskiy, A., Wang, C. -. Y., Liao, H. -. Y. M. YOLOv4: optimal speed and accuracy of object detection. arXiv. , 10934 (2004).

- Huang, G., Liu, Z., vander Maaten, L., Weinberger, K. Q. Densely connected convolutional networks. arXiv. , 06993 (2018).

- . CDC-DPDx. Diagnostic procedures - Blood specimens Available from: https://www.cdc.gov/dpdx/diagosticprocedures/blood/specimenproc.html#print (2020)

- Control and surveillance of African trypanosomiasis: report of a WHO expert committee. WHO Technical Report Series 881 Available from: https://iris.who.int/bitstream/handle/10665/42087/WHO_TRS_881.pdf?sequence=1 (1998)

- Leber, A. L. Detection of blood parasites. Clinical Microbiology Procedures Handbook. , (2022).

- Huang, L. -. P., Hong, M. -. H., Luo, C. -. H., Mahajan, S., Chen, L. -. J. A vector mosquitoes classification system based on edge computing and deep learning. Proceedings-2018 Conmference on Technologies and Applications of Artifical Intelligence. , 24-27 (2018).

- Cihan, P., Gökçe, E., Kalipsiz, O. A review of machine learning applications in veterinary field. Kafkas Universitesi Veteriner Fakultesi Dergisi. 23 (4), 673-680 (2017).

- Berrar, D. Cross-validation. Encyclopedia of Bioinformatics and Computational Biology. 1, 542-545 (2019).

- Gaithuma, A. K., et al. A single test approach for accurate and sensitive detection and taxonomic characterization of Trypanosomes by comprehensive analysis of internal transcribed spacer 1 amplicons. PLoS Neglected Tropical Diseases. 13 (2), 0006842 (2019).

- Vijayalakshmi, A., Rajesh Kanna, B. Deep learning approach to detect malaria from microscopic images. Multimedia Tools and Applications. 79 (21-22), 15297-15317 (2019).

- Morais, M. C. C., et al. Automatic detection of the parasite Trypanosoma cruzi in blood smears using a machine learning approach applied to mobile phone images. PeerJ. 10, 13470 (2022).

- Uc-Cetina, V., Brito-Loeza, C., Ruiz-Pina, H. Chagas parasite detection in blood images using AdaBoost. Computational and Mathematical Methods in Medicine. 2015, 139681 (2015).

- Zhang, C., et al. Deep learning for microscopic examination of protozoan parasites. Computational and Structural Biotechnology Journal. 20, 1036-1043 (2022).

- Sarataphan, N., et al. Diagnosis of a Trypanosoma lewisi-like (Herpetosoma) infection in a sick infant from Thailand. Journal of Medical Microbiology. 56, 1118-1121 (2007).

- Desquesnes, M., et al. A review on the diagnosis of animal trypanosomoses. Parasites & Vectors. 15 (1), 64 (2022).

- Fuhad, K. M. F., et al. Deep learning based automatic malaria parasite detection from blood smear and its smartphone based application. Diagnostics (Basel). 10 (5), 329 (2020).

- Christian Matek, S. S., Spiekermann, K., Marr, C. Human-level recognition of blast cells in acute myeloid leukaemia with convolutional neural networks. Nature Machine Intelligence. 1, 538-544 (2019).

- Hamdan, S., Ayyash, M., Almajali, S. Edge-computing architectures for internet of things applications: a survey. Sensors (Basel). 20 (22), 6441 (2020).

- Visser, T., et al. A comparative evaluation of mobile medical APPS (MMAS) for reading and interpreting malaria rapid diagnostic tests. Malaria Journal. 20 (1), 39 (2021).

- Giorgi, E., Macharia, P. M., Woodmansey, J., Snow, R. W., Rowlingson, B. Maplaria: a user friendly web-application for spatio-temporal malaria prevalence mapping. Malaria Journal. 20 (1), 471 (2021).

- Rajaraman, S., Jaeger, S., Antani, S. K. Performance evaluation of deep neural ensembles toward malaria parasite detection in thin-blood smear images. PeerJ. 7, 6977 (2019).

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유