Zum Anzeigen dieser Inhalte ist ein JoVE-Abonnement erforderlich. Melden Sie sich an oder starten Sie Ihre kostenlose Testversion.

Method Article

Überlegene automatische Identifizierung von Trypanosomenparasiten durch Verwendung eines hybriden Deep-Learning-Modells

In diesem Artikel

Zusammenfassung

Weltweit wurden medizinische Blutparasiten in einfachen Schritten auf einer Low-Code-KI-Plattform automatisch gescreent. Die prospektive Diagnose von Blutausstrichen wurde durch den Einsatz einer Objekterkennungs- und Klassifikationsmethode in einem hybriden Deep-Learning-Modell verbessert. Das Zusammenwirken von aktivem Monitoring und gut trainierten Modellen hilft, Hotspots der Trypanosomenübertragung zu identifizieren.

Zusammenfassung

Trypanosomiasis ist ein bedeutendes Problem der öffentlichen Gesundheit in mehreren Regionen der Welt, darunter Südasien und Südostasien. Die Identifizierung von Hotspot-Gebieten unter aktiver Überwachung ist ein grundlegendes Verfahren zur Kontrolle der Krankheitsübertragung. Die mikroskopische Untersuchung ist eine häufig verwendete diagnostische Methode. Sie ist jedoch in erster Linie auf qualifiziertes und erfahrenes Personal angewiesen. Um dieses Problem anzugehen, wurde ein Programm für künstliche Intelligenz (KI) eingeführt, das eine hybride Deep-Learning-Technik aus neuronalen Netzwerk-Backbones zur Objektidentifikation und Objektklassifizierung auf der hauseigenen Low-Code-KI-Plattform (CiRA CORE) nutzt. Das Programm kann die protozoischen Trypanosomenarten, nämlich Trypanosoma cruzi, T. brucei und T. evansi, anhand von mikroskopischen Bildern identifizieren und klassifizieren. Das KI-Programm nutzt Mustererkennung, um mehrere Protozoen in einer einzigen Blutprobe zu beobachten und zu analysieren, und hebt den Zellkern und den Kinetoplast jedes Parasiten als spezifische charakteristische Merkmale mithilfe einer Aufmerksamkeitskarte hervor.

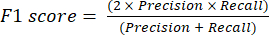

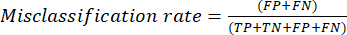

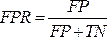

Um die Leistung des KI-Programms zu bewerten, werden zwei einzigartige Module erstellt, die eine Vielzahl statistischer Messgrößen wie Genauigkeit, Abruf, Spezifität, Präzision, F1-Score, Fehlklassifizierungsrate, ROC-Kurven (Receiver Operating Characteristics) und PR-Kurven (Precision versus Recall) bereitstellen. Die Bewertungsergebnisse zeigen, dass der KI-Algorithmus Parasiten effektiv identifizieren und kategorisieren kann. Durch die Bereitstellung eines schnellen, automatisierten und präzisen Screening-Tools hat diese Technologie das Potenzial, die Überwachung und Kontrolle von Krankheiten zu verändern. Es könnte auch lokalen Beamten dabei helfen, fundiertere Entscheidungen über Strategien zur Blockierung der Krankheitsübertragung zu treffen.

Einleitung

Trypanosomiasis ist eine große Herausforderung für globale Gesundheitsprobleme, da es eine Vielzahl von Zoonosearten gibt, die menschliche Krankheiten verursachen und außerhalb des afrikanischen und amerikanischen Kontinents, wie z. B. Süd- und Südostasien, geografisch weit verbreitet sind 1,2,3. Die humane afrikanische Trypanosomiasis (HAT) oder Schlafkrankheit wird durch Trypanosoma brucei gambiense und T. b. rhodesiense verursacht, die die chronischen bzw. akuten Formen hervorrufen, die die größte Verbreitung in Afrika darstellen. Der ursächliche Parasit gehört aufgrund der Übertragung von Tsetse-Fliegen durch infizierten Speichel zur Gruppe der Salivaria4. in der Erwägung, dass die bekannte amerikanische Trypanosomiasis (Chagas-Krankheit), die durch T. cruzi verursacht wird, für nicht endemische Länder ein Problem für die öffentliche Gesundheit darstellt. einschließlich Kanada, den USA, Europa, Australien und Japan, wegen der häufigen Migration von Individuen aus endemischen Gebieten5. Die Trypanosomeninfektion gehört zur Gruppe der Stercorarien, da sie durch den infizierten Kot von reduviiden Wanzen übertragen wird. Die durch die T. evansi-Infektion verursachten Trypanosomiasen und Trypanosomosen (Surra-Krankheit) sind in Afrika, Südamerika, West- und Ostasien sowie in süd- und südostasiatischen Ländern endemisch 3,6. Obwohl über die durch das Trypanosom verursachte humane Trypanosomiasis berichtet wurde 3,4,7,8,9,10,11,12, ist der Übertragungsweg der Parasiteninfektion umstritten: entweder das mechanische oder infizierte Blut durch hämatophage Insekten wie Tsetsefliegen und Tabaniden oder Bremsen 6,7, 8,9,10,12,13,14. In Thailand wurde kein Fallbericht gefunden, jedoch wurde eine hohe Prävalenz der T. evansi-Infektion bei Hunden15, Rennpferden und Wasserbüffeln in der östlichen Region veröffentlicht16, was auf eine erworbene Übertragung zwischen Haustieren hindeutet. Es wurden mehrere atypische Infektionen beim Menschen durch tierische Trypanosomen (T. vivax, T. b. brucei, T. congolense, T. lewisi und T. evansi) beschrieben, die nicht die klassischen Formen menschlicher Trypanosomen sind17. Das Bewusstsein für atypische Infektionen beim Menschen könnte unterschätzt werden, was die Notwendigkeit verbesserter diagnostischer Tests und Felduntersuchungen zur Erkennung und Bestätigung dieser atypischen Fälle unterstreicht und eine angemessene Kontrolle und Behandlung von tierpathogenen Krankheiten ermöglicht, die den weltweiten Viehbestand, die Ernährungssicherheit18 und die menschliche Gesundheitsversorgung betreffen. Dies führte zur Entwicklung einer potenziellen Strategie, die in eine bestehende gängige Methode (mikroskopische Untersuchung) integriert ist, um Blutproben in abgelegenen Gebieten während der aktiven Überwachung schnell zu untersuchen und so die Identifizierung der Hotspot-Zonen zur Eindämmung und Kontrolle der Krankheit zu ermöglichen.

Ein sporadisches Auftreten der Surra-Krankheit bei einer Vielzahl von Haustieren wie Dromedaren, Rindern, Pferden und Hunden, die einen euryxenous T. evansi hervorrufen, kann für den Menschen zoonotisch sein 1,4,13,14. Eine Infektion beim Menschen scheint unmöglich zu sein, da ein trypanolytischer Faktor im menschlichen Serum, der von einem sra-ähnlichen Gen exprimiert wird, in der Lage ist, menschliches T. brucei und T. congolense zu verhindern 12,19. Darüber hinaus hat die Krankheit, wie der erste Fallbericht aus Indien zeigt, keinen Zusammenhang mit immungeschwächten HIV-Patienten4. Wie oben beschrieben, kann die mögliche Infektion beim Menschen mit einem High-Density-Lipoprotein-Mangel mit abnormaler Funktion des lytischen Trypanosomenfaktors zusammenhängen, bei dem es sich um eine seltene autosomal-rezessive genetische Erkrankung, nämlich die Tanger-Krankheit4, handelt. Im Jahr 2016 wurde bei einem vietnamesischen Patienten festgestellt, dass er zwei Wildtyp-APOL1-Allele und eine APOL1-Serumkonzentration im Normbereich besaß. Die Theorie des APOL-1-Mangels gilt jedoch nicht mehr als gültig12. Ein möglicher Mechanismus der Trypanosomeninfektion ist daher der direkte Kontakt einer Wunde mit infiziertem Tierblut während der beruflichen Tierhaltung 4,12. Die mikroskopische Untersuchung zeigt, dass die Morphologie von T. evansi eine monomorphe Form des Trypomastigoten ist, die ein vorherrschendes, langes, schlankes, geißelndes und sich teilendes Trypanosom enthält, das ihrer verwandten Art von T. bruceiähnelt 1,12,13. Der Kern befindet sich in der zentralen Position mit einem sichtbaren kleinen Kinetoplast in der posterioren Position. Eine frühere Studie deutete darauf hin, dass der Parasit in zwei vergleichbaren Formen existieren kann, die als klassische und verkürzte Form bekannt sind. Es bleibt jedoch notwendig, ihre jeweiligen pathogenen Wirkungen auf Wirtezu bestätigen 20. Der Verlauf der Symptome variiert und reicht von intermittierendem Fieber in Verbindung mit Schüttelfrost und Schwitzen. Suramin ist glücklicherweise eine erfolgreiche Erstlinientherapie für die frühe menschliche afrikanische Trypanosomiasis ohne Invasion des zentralen Nervensystems (ZNS) und heilt Patienten in Indien und Vietnam 4,12,21.

Abgesehen von der klinischen Symptomuntersuchung gibt es mehrere diagnostische Methoden für T. evansi-Parasiten, darunter parasitologische mikroskopische Beobachtungen 4,9,12, serologische 4,8,9,10,12 und molekularbiologische Tests 4,12. Mit Giemsa gefärbte Dünnblutfilme werden häufig verwendet, um den vorhandenen Parasiten unter mikroskopischer Untersuchung sichtbar zu machen, was routinemäßig und häufig verwendet wird22. Das Verfahren scheint jedoch machbar zu sein; Nichtsdestotrotz ist es zeit- und arbeitsintensiv, hat eine Inter-Rater-Bewertungsvariabilität, ist nur für eine akute Phase empfindlich und erfordert einen persönlichen Praktikanten23. Sowohl die Molekularbiologie als auch die serologischen Tests erforderten hochqualifiziertes Personal, um mehrere Prozesse der Probenvorbereitung durchzuführen, einschließlich der Extraktion und Reinigung der Proben vor der Untersuchung mit teuren Geräten, die schwer zu standardisieren sind, dem Risiko einer Kontamination mit extraparasitären Materialien und Diskrepanzen in den Ergebnissen24. Auf der Grundlage der oben beschriebenen Logik ist eine schnelle und frühzeitige Screening-Technologie erforderlich, um die Feldüberwachungsstudie zu unterstützen und sicherzustellen, dass das Erhebungsergebnis rechtzeitig gemeldet wird, um die Hotspot-Zone für eine weitere Kontrolle der Krankheitsübertragung zu ermitteln 1,8. Computergestützte Geräte (CAD) wurden als innovative Technologie für medizinische Bereiche, einschließlich histopathologischer und zytopathologischer Aufgaben, vorgeschlagen25. Das oben erwähnte CAD wurde mit hoher Geschwindigkeit durchgeführt und mit Hilfe von Mustererkennung, also künstlicher Intelligenz (KI), berechnet. Die KI-Methode wird durch die Verwendung von Convolutional Neural Network-Algorithmen erreicht, die für den Umgang mit einer großen Anzahl von Datensätzen verwendet werden können, insbesondere ein überwachter Lernansatz, der ein gut trainiertes Modell beim Datenverbrauch trainiert.

Im Allgemeinen ist KI die Fähigkeit von Computern, Aufgaben zu lösen, die Expertenintelligenz erfordern, wie z. B. die Kennzeichnung von Daten. Maschinelles Lernen (ML), ein Teilgebiet der KI, wird als Computersystem mit zwei verschiedenen Prozessen dargestellt, die sich aus der Merkmalsextraktion und der Mustererkennung zusammensetzen. Deep Learning (DL) oder fortschrittliche ML-Algorithmen beziehen sich auf die Entwicklung computergestützter Programme und Geräte, die menschenähnliche Leistungen mit einer Genauigkeit vergleichen, die größer und gleich ist als die von menschlichen Fachleuten26. Gegenwärtig wird die Rolle von DL im medizinischen und veterinärmedizinischen Bereich vielversprechend ausgeweitet und revolutioniert die Prävention übertragbarer Krankheiten mit dem Ziel, sie in jüngster Zeit zu prägnieren und auf das individuelle Gesundheitspersonal auszurichten22,27. Die potenziellen DL-Anwendungen sind mit Qualitätssiegeln und einer großen Anzahl erweiterter Datensätze grenzenlos, so dass Spezialisten die Projektaufgabe bewältigen können. Insbesondere ein Fortschritt im digitalen Bild zusammen mit der computergestützten Analyse verbesserte die automatische Diagnose und das Screening in fünf Kategorien der berichteten Pathologie; einschließlich statischer, dynamischer, robotergestützter, ganzer Objektträgerbildgebung und hybrider Verfahren28. Es ist zu berücksichtigen, dass die Integration von DL-Algorithmus-Ansätzen und digitalen Bilddaten lokale Mitarbeiter dazu ermutigen könnte, die Technologie in ihrer täglichen Praxis zu nutzen.

Zuvor war die Erhöhung der Vorhersagegenauigkeit durch die Verwendung eines Hybridmodells nachgewiesenworden 27. Um den Trypanosomenparasiten in mikroskopischen Bildern zu identifizieren, werden in dieser Arbeit zwei Hybridmodelle vorgestellt, die die Algorithmen YOLOv4-tiny (Objekterkennung) und Densenet201 (Objektklassifizierung) enthalten. Unter mehreren Detektionsmodellen zeigte YOLOv4-tiny mit einem CSPDarknet53-Backbone eine hohe Leistung als Vorhersageergebnis in Bezug auf Lokalisierung und Klassifizierung29. Da der Echtzeitdetektor die optimale Balance zwischen der Auflösung des Eingangsnetzwerks, der Menge der Faltungsschicht, dem Gesamtparameter und der Anzahl der Schichtausgänge geändert hat, hat er im Vergleich zu früheren Versionen die Priorisierung schneller Betriebsgeschwindigkeiten und die Optimierung für parallele Berechnungen verbessert. Dense Convolutional Network (DenseNet) ist ein weiteres beliebtes Modell, das modernste Ergebnisse über konkurrierende Datensätze hinweg erzielt. DenseNet201 ergab einen ähnlichen Validierungsfehler, der mit dem von ResNet101 vergleichbar ist. DenseNet201 hat jedoch weniger als 20 Millionen Parameter, was weniger ist als die mehr als 40 Millionen Parameter von ResNet10130. Daher könnte das DenseNet-Modell die Vorhersagegenauigkeit mit einer zunehmenden Anzahl von Parametern verbessern, ohne dass es Anzeichen für eine Überanpassung gibt. Hier nutzt ein Programm der künstlichen Intelligenz (KI) einen hybriden Deep-Learning-Algorithmus mit tiefen Erkennungs- und Klassifikations-Backbones neuronaler Netze auf der hauseigenen CiRA CORE-Plattform. Das entwickelte Programm ist in der Lage, die protozoischen Trypanosomenarten, nämlich Trypanosoma cruzi, T. brucei und T. evansi, anhand von mikroskopischen Aufnahmen zu identifizieren und zu klassifizieren. Diese Technologie hat das Potenzial, die Überwachung und Kontrolle von Krankheiten zu revolutionieren, indem sie eine schnelle, automatisierte und genaue Screening-Methode bietet. Es könnte den lokalen Mitarbeitern helfen, fundiertere Entscheidungen über Strategien zur Blockierung der Übertragung bei parasitären Protozoenerkrankungen zu treffen.

Protokoll

Die archivierten Blutausstriche und das Projektdesign wurden vom Institutionellen Ausschuss für Biosicherheit, dem Institutionellen Ausschuss für Tierpflege und -verwendung der Fakultät für Veterinärwissenschaften der Chulalongkorn-Universität (IBC Nr. 2031033 und IACUC Nr. 1931027) und dem Ethikausschuss für Humanforschung des King Mongkut's Institute of Technology Ladkrabang (EC-KMITL_66_014) genehmigt.

1. Vorbereitung der Rohbilder

- Die Vorbereitung des Bilddatensatzes

- Erhalten Sie mindestens 13 positive Objektträger mit Blutparasiteninfektionen, darunter T. brucei, T. cruzi und T. evansi, die von Parasitologen bestätigt wurden. Trennen Sie die 13 Folien für Training (10 Folien) und Tests (drei Folien).

- Aufnahme von Bildern der oben beschriebenen Giemsa-gefärbten dünnen Blutausstriche unter einem Ölimmersionsfeld eines Lichtmikroskops mit einer Digitalkamera. Aufnahme von Bildern, die mehrere Objekte der Trypomastigoten aller drei mikroskopisch untersuchten Parasitenarten enthalten; Achte auf eine schlanke Form, lange Schwänze, eine wellenförmige Membran und einen Kinetoplast am vorderen Ende.

HINWEIS: Das Anlegen von dicken und dünnen Abstrichen würde den Nachweis von Trypanosomiasis in der akuten Phase verbessern31. Die Blutentnahme durch Stechen in den Finger wird von der WHOempfohlen 32. Nichtsdestotrotz sind dünne Schichten effektiver bei der Identifizierung von Trypanosoma cruzi und anderen Arten, da diese Organismen dazu neigen, in dicken Schichten verzerrt zu werden33. Vor diesem Hintergrund haben wir dünne Blutfilmbilder verwendet, um die geeignete Morphologie der Parasiten für diese Studie aufrechtzuerhalten. - Speichern Sie alle Bilder in einem parasitenspezifischen Ordner mit den folgenden Spezifikationen: 1.600 x 1.200 Pixel, 24-Bit-Tiefe und JPG-Dateiformat. Teilen Sie die Bilder in einem Verhältnis von ~6:1 in die Trainings- und Testsätze auf.

HINWEIS: Siehe https://gitlab.com/parasite3/superior-auto-identification-of-medically-important-trypanosome-parasites-by-using-a-hybrid-deep-learning-model/-/blob/main/JOVEimage.zip; 650 Bilder wurden in ein Trainings- (560 Bilder) und ein Testmodell (90 Bilder) aufgeteilt. - Definieren Sie den Interessenbereich als rechteckige Beschriftung für zwei Klassen: Trypanosomen und Nicht-Trypanosomen. Verwenden Sie das Modul für das automatische Zuschneiden, um alle erkannten Bilder mithilfe des gut trainierten Objekterkennungsmodells zuzuschneiden. Das Auto-Cropping-Modul ist das Modul, das im hauseigenen CiRA CORE-Programm entwickelt wurde (siehe Materialtabelle). Erfassen Sie ein einzelnes Objekt pro Bild, um die Objektklassifizierung zu trainieren.

HINWEIS: Für diese Arbeit wurden 1.017 Bilder zu Trainingszwecken (892 Bilder) und Tests (126 Bilder) aufgeteilt. Das Modelltraining wurde mit vier markierten Klassen durchgeführt, darunter Leukozyten, T. brucei, T. cruzi und T. evansi.

2. Schulungsprozess mit der hauseigenen CiRA CORE-Plattform

- Ein neues Projekt starten

- Öffnen Sie die CiRA CORE-Anwendung vom Desktop des Computers aus (siehe Materialtabelle) und erstellen Sie ein neues Projekt, indem Sie auf das Symbol des Programms doppelklicken.

- Wählen Sie das Bedienungssymbol in der linken vertikalen Symbolleiste aus, um die erforderlichen Werkzeuge auszuwählen.

- Training des Objekterkennungsmodells

- Wählen Sie die Modellfunktion training-dl für die Datenbeschriftung und das Training mithilfe der Drag-and-Drop-Methode aus. Gehen Sie zur Symbolleiste Allgemein | CiRA KI | Ziehen von DeepTrain | Legen Sie DeepTrain auf dem Bildschirm (rechte Seite) ab.

HINWEIS: Um weitere Optionen anzuzeigen, klicken Sie mit der rechten Maustaste auf das ausgewählte Werkzeug und führen Sie die entsprechenden Funktionen aus: Kopieren, Ausschneiden oder Löschen. - Importieren Sie die Bilder mit den Einstellungen des DeepTrain-Tools. Klicken Sie auf die Schaltfläche Bilder laden und navigieren Sie zum Bildverzeichnis. Beschriften Sie die Objekte, indem Sie die linke Maustaste gedrückt halten und das ausgewählte Objekt benennen. Passen Sie die Dicke der Rechtecklinie und die Schriftgröße an, indem Sie auf die Schaltfläche Anzeigeeinstellung klicken und GT als .gt-Datei im selben Verzeichnis speichern .

HINWEIS: Speichern Sie nach Bedarf, um unerwünschte Zustände wie Stromausfall, automatisches Schließen des Programms und Hängungen innerhalb des Etikettierprozesses zu vermeiden. - Erweitern Sie vor dem Modelltraining die Daten, um mithilfe der vier Augmentationstechniken ( Rotation, Kontrast, Rauschen und Unschärfe) ausreichende Informationen zu sammeln. Klicken Sie auf die Schaltfläche Gen-Einstellung , um auf diese Funktion zuzugreifen.

- Initiieren Sie das Modelltraining, indem Sie im DeepTrain-Tool auf die Schaltfläche Training klicken. Der Trainingsteil hat zwei Unterfunktionen: Trainingsdateien generieren und Trainieren. Wählen Sie unter der Funktion Trainingsdateien generieren die gewünschten Modelle, die Batchgröße und die Unterteilungen aus. Klicken Sie auf die Schaltfläche Generieren, um Daten zu generieren und im Verzeichnis zu speichern. Wählen Sie in der Funktion "Trainieren" die folgenden Optionen aus: i) Verwenden Sie einen anderen generierten Trainingsort für Bedingungen und Backups, ii) verwenden Sie vordefinierte Gewichtungen für das weitere Training oder iii) überschreiben Sie Parameter für das aktuelle Trainingsdesign. Dadurch werden die Modellkonfiguration und die Trainingsbedingungen entworfen.

HINWEIS: Die Zeit des Generierungsprozesses hängt von der Größe der Bilddatei, der Erweiterungsnutzung und dem verfügbaren Speicherplatz ab. - Sobald alle erforderlichen Konfigurationen abgeschlossen sind, beginnen Sie mit dem Modelltraining, indem Sie auf die Schaltfläche Trainieren klicken. Lassen Sie das Programm kontinuierlich ausführen, indem Sie den Trainingsverlust auswerten und die Gewichtung des Datensatzes während des Trainingsprozesses anpassen. Wenn das Modell einen optimalen Verlust erreicht, speichern Sie die trainierte Gewichtsdatei im angegebenen Verzeichnis, indem Sie auf die Schaltfläche Exportieren klicken.

- Wählen Sie die Modellfunktion training-dl für die Datenbeschriftung und das Training mithilfe der Drag-and-Drop-Methode aus. Gehen Sie zur Symbolleiste Allgemein | CiRA KI | Ziehen von DeepTrain | Legen Sie DeepTrain auf dem Bildschirm (rechte Seite) ab.

3. Evaluierung des Objekterkennungsmodells

- Wählen Sie die Objekterkennungsmodell-Auswertungsfunktion für die Modellauswertung per Drag-and-Drop-Methode aus. Gehen Sie zur Plugin-Symbolleiste | Evaluieren | Ziehen Sie EvalDetect | Legen Sie EvalDetect auf dem Bildschirm (rechte Seite) ab.

- Klicken Sie auf Einstellung und warten Sie auf drei Funktionen: Erkennen, Auswerten und Plotten. Starten Sie die Modellauswertung, indem Sie die trainierte Gewichtsdatei aus dem Verzeichnis importieren (Schritt 2.2.5), indem Sie auf Load Config klicken.

- Wählen Sie unter der Funktion "Erkennung " den Wert für die nicht-maximale Unterdrückung (NMS) aus, um die Genauigkeit zu erhöhen, indem redundante Falsch-Positiv-Erkennungen (FP) eliminiert werden. NMS entfernt doppelte modellgenerierte Erkennungen, um die Zuverlässigkeit zu verbessern.

- Fahren Sie mit den folgenden Schritten unter der Funktion Auswertung fort:

- Importieren Sie Testbilder aus dem Bilddateiverzeichnis, indem Sie auf Durchsuchen klicken. Importieren Sie die GT-Datei aus dem Verzeichnis, in dem sie in Schritt 2.2.2 gespeichert wurde, indem Sie auf GT laden klicken.

- Wählen Sie den Wert Intersection over Union (IoU) aus, um die Genauigkeit des jeweiligen Bildtestdatensatzes zu bewerten.

- Klicken Sie auf die Schaltfläche Auswertung , um das Erkennungsmodell im angegebenen Verzeichnis zu bewerten. Sobald die Auswertung abgeschlossen ist, werden die Ergebnisse automatisch als CSV-Datei im selben Verzeichnis gespeichert, sortiert nach Klassennamen. Diese CSV-Datei enthält wichtige Parameter wie True Positive (TP), False Positive (FP), False Negative (FN), Recall und Precision für jede Klasse.

- Um die PR-Kurve (Precision-Recall) zu zeichnen, gehen Sie wie folgt vor : Importieren Sie die CSV-Dateien aus dem Verzeichnis des vorherigen Abschnitts (Schritt 3.4), indem Sie auf Durchsuchen klicken. Wählen Sie Klassen aus der Liste aus und klicken Sie auf die Schaltfläche Plotten , um das bearbeitbare PR-Kurvenbild anzuzeigen.

- Um abschließend ein Bild mit den AUC-Werten der PR-Kurve im gewünschten Bildformat im angegebenen Verzeichnis zu speichern, klicken Sie auf die Schaltfläche Speichern des Bildes.

4. Bildzuschnitt für ein einzelnes Objekt pro Bild

- Führen Sie vor dem Zuschneiden der Bilder die folgenden Schritte aus:

- Importieren Sie die Bilder aus dem Bilddateiverzeichnis, indem Sie auf die Einstellungen des Bildfolien-Werkzeugs zugreifen.

- Importieren Sie die (in Schritt 2.2.8 gespeicherte) trainierte Gewichtsdatei, indem Sie auf die Einstellungen des Tiefenerkennungswerkzeugs zugreifen. Klicken Sie auf die Schaltfläche Konfiguration | +, wählen Sie das Backend (CUDA oder CPU) aus, geben Sie einen Namen ein, klicken Sie auf OK, wählen Sie das Verzeichnis der Gewichtsdatei aus und klicken Sie auf Auswählen. Wählen Sie im Werkzeug "Tiefenerkennung" die Erkennungsparameter aus (Schwellenwert und Nicht-Maxima-Unterdrückung (nms)); Zeichnungsparameter; Tracking-Parameter; und ROI-Parameter (Region of Interest).

- Wählen Sie das Verzeichnis aus, in dem die zugeschnittenen Bilder gespeichert werden sollen, indem Sie auf die Einstellungen des Werkzeugs "Tiefes Zuschneiden " zugreifen. Klicken Sie auf Durchsuchen | Wählen Sie das Verzeichnis aus, in dem die zugeschnittenen Bilder gespeichert werden sollen | Klicken Sie auf Auswählen | Wählen Sie das Bildformat (jpg oder png) | Aktivieren Sie die Option Automatisch speichern.

- Schneiden Sie Bilder zu, um ein einzelnes Objekt pro Bild für die Bildklassifizierung und -segmentierung zu erhalten. Um diesen Vorgang durchzuführen, verwenden Sie vier Werkzeuge und stellen Sie Verbindungen zwischen ihnen her: Gehen Sie zur Symbolleiste Allgemein | Allgemeines | Schaltfläche Ausführen. Navigieren Sie als Nächstes zur Symbolleiste Allgemein | CiRA KI | DeepDetect; Gehen Sie dann zu Allgemeine Symbolleiste | CiRA KI | DeepCrop. Gehen Sie abschließend zur Bildsymbolleiste | Akquisition | ImageSlide.

- Sobald alle erforderlichen Einstellungen vorgenommen wurden, starten Sie den Bildzuschneidevorgang, indem Sie auf das Werkzeug Schaltfläche Ausführen klicken.

- Rufen Sie ein neues Bildtrainingsdataset ab, das aus Einzelobjektbildern mit einer Größe von 608 x 608 besteht.

5. Bildklassifizierung als Modelltraining

- Verwenden Sie Drag-and-Drop, um die Trainingsfunktion des Bildklassifizierungsmodells für das Datentraining auszuwählen. Gehen Sie zur Bild-Symbolleiste | DeepClassif | Ziehen Sie ClassifTrain | Legen Sie ClassifTrain auf dem Bildschirm ab.

- Importieren Sie Bilder für das Modelltraining mithilfe der Einstellungen des ClassifTrain-Werkzeugs. Klicken Sie auf die Schaltfläche Ordner öffnen und navigieren Sie zum gewünschten Bildverzeichnis. Erweitern Sie vor dem Training die Daten, indem Sie auf die Schaltfläche "Verstärkung" klicken, um weitere Informationen zu Techniken wie "Rotation", "Kontrast", "Spiegeln" (horizontal und/oder vertikal), "Rauschen" und "Weichzeichnen" zu erhalten.

- Um mit dem Modelltraining zu beginnen, klicken Sie auf die Schaltfläche GenTrain des Werkzeugs ClassifTrain . Wählen Sie unter der Funktion GenTrain die Modelle, die Losgröße und die Unterteilungen aus. Weisen Sie ein Verzeichnis zu, in dem die generierte Datei gespeichert werden soll. Klicken Sie auf die Schaltfläche Generieren, um mit den Daten für das Training fortzufahren. Aktivieren Sie in der Funktion Trainieren die entsprechenden Optionen: Training mit Standardgewicht oder benutzerdefiniertem Gewicht fortsetzen.

HINWEIS: Der Generierungsprozess kann einige Zeit in Anspruch nehmen, abhängig von Faktoren wie der Größe der Bilddatei, der Verwendung von Erweiterungen, dem Klassenausgleich und dem verfügbaren Speicherplatz. - Sobald alle Vorbereitungen abgeschlossen sind, starten Sie das Modelltraining, indem Sie auf die Schaltfläche Start klicken. Lassen Sie das Programm kontinuierlich ausführen, indem Sie den Trainingsverlust auswerten und die Gewichtung des Datensatzes während des Trainingsprozesses anpassen. Wenn das Modell den gewünschten Verlustgrad erreicht, speichern Sie die trainierte Gewichtsdatei im angegebenen Verzeichnis, indem Sie auf die Schaltfläche Exportieren klicken.

6. Bewertung des Klassifikationsmodells

- Wählen Sie die Bildklassifizierungsmodell-Auswertungsfunktion für die Modellauswertung per Drag-and-Drop-Methode aus. Gehen Sie zur Plugin-Symbolleiste | Evaluieren | Ziehen Sie EvaluateClassif | Legen Sie EvaluateClassif auf dem Bildschirm (auf der rechten Seite) ab.

- Klicken Sie auf Einstellung , um auf zusätzliche Funktionen innerhalb des Werkzeugs EvaluateClassif zuzugreifen, nämlich Auswerten und PlotROC.

- Um die Modellauswertung zu starten, klicken Sie im Werkzeug EvaluateClassif auf die Schaltfläche Auswerten. Führen Sie die folgenden Schritte unter der Funktion Auswerten aus.

- Importieren Sie die Testbilder aus dem Bilddateiverzeichnis, indem Sie auf das Ordnerbild laden klicken. Importieren Sie die trainierte Gewichtsdatei aus dem Verzeichnis (gespeichert in Schritt 5.4), indem Sie auf Load Config klicken. Klicken Sie auf die Schaltfläche Start , um das Klassifizierungsmodell auszuwerten.

- Sobald die Auswertung abgeschlossen ist, speichern Sie die ausgewertete Datei als CSV im angegebenen Verzeichnis, indem Sie auf die Schaltfläche In CSV exportieren klicken. Für die Auswertung der Daten bei jedem Schwellwert speichern Sie die CSV-Datei mit Klassennamen im angegebenen Verzeichnis, indem Sie auf Alle Schwellwerte starten klicken. Die gespeicherte CSV-Datei enthält Parameter wie Recall (True Positive Rate), False Positive Rate und Precision für jede Klasse.

- Um die ROC-Kurve (Receiver Operating Characteristics) zu zeichnen, klicken Sie auf die Schaltfläche PlotROC im Werkzeug EvaluateClassif . Befolgen Sie diese Schritte unter der Funktion PlotROC .

- Importieren Sie CSV-Dateien aus dem zuvor abgerufenen Verzeichnis, indem Sie auf Durchsuchen klicken. Überprüfen Sie die importierte Klassenliste, und wählen Sie jede Klassenbezeichnung aus, um die ROC-Kurve zu zeichnen.

- Klicken Sie auf die Schaltfläche Plotten , um die ROC-Kurve als Bild zu visualisieren. Nehmen Sie die gewünschten Bearbeitungen vor, um die Bildeigenschaften anzupassen, einschließlich Schriftgröße, Schriftfarben, Dezimalstellen, Linienstile und Linienfarben.

- Speichern Sie abschließend ein Bild der ROC-Kurve mit den AUC-Werten im gewünschten Bildformat im angegebenen Verzeichnis, indem Sie auf die Schaltfläche Speichern klicken.

7. Testen des Prozesses mit der CiRA CORE-Anwendung

- Objekterkennung als Modelltest

- Um Modelltests durchzuführen, verwenden Sie vier Tools und stellen Sie Verbindungen zwischen ihnen her. Gehen Sie zur Symbolleiste Allgemein | Allgemeines | Schaltfläche Ausführen. Klicken Sie dann auf die Symbolleiste Allgemein | Allgemeines | Debuggen. Klicken Sie danach auf die Symbolleiste Allgemein | CiRA KI | DeepDetect und schließlich Bild-Symbolleiste | Akquisition | ImageSlide.

- Gehen Sie folgendermaßen vor, bevor Sie die Bilder testen:

- Importieren Sie die Testbilder aus dem Bilddateiverzeichnis, indem Sie im Bildfolien-Werkzeug auf die Option Einstellung klicken.

- Importieren Sie die gespeicherte Datei mit dem trainierten Gewicht aus Schritt 2.2.8, indem Sie im DeepDetect-Tool auf die Option Einstellung klicken. Klicken Sie auf die Schaltfläche Config, dann auf die Schaltfläche +, wählen Sie das Backend (CUDA oder CPU) aus, geben Sie einen Namen ein, klicken Sie auf OK, wählen Sie das Verzeichnis der Gewichtsdatei aus und klicken Sie auf Auswählen. Wählen Sie unter dem Werkzeug DeepDetect die Erkennungsparameter (Schwellenwert und nms), die Zeichnungsparameter, die Tracking-Parameter und die ROI-Parameter aus.

- Zeigen Sie die Ergebnisse des Testbilds an, indem Sie im Debug-Tool auf die Bildfunktion klicken.

- Überprüfen Sie abschließend die vorhergesagten Ergebnisse für jedes Bild, indem Sie auf die Schaltfläche Ausführen im Werkzeug Schaltfläche Ausführen klicken.

- Bildklassifizierung als Modellversuch

- Um Modelltests durchzuführen, verwenden Sie vier Tools und stellen Sie Verbindungen zwischen ihnen her. Gehen Sie zur Symbolleiste Allgemein | Allgemeines | Schaltfläche Ausführen; Klicken Sie dann auf Allgemeine Symbolleiste | Debuggen. Navigieren Sie danach zu Bildsymbolleiste | Akquisition | ImageSlide und schließlich Bildsymbolleiste | DeepClassif | DeepClassif.

- Gehen Sie folgendermaßen vor, bevor Sie die Bilder testen:

- Importieren Sie die Testbilder aus dem Bilddateiverzeichnis, indem Sie im Bildfolien-Werkzeug auf die Option Einstellung klicken.

- Importieren Sie die gespeicherte Datei mit dem trainierten Gewicht aus Abschnitt 5.5, indem Sie im DeepClassif-Tool auf die Option Einstellung klicken. Klicken Sie auf die Schaltfläche Config | + | Wählen Sie das Backend (CUDA oder CPU) | Geben Sie einen Namen an | Klicken Sie auf OK | Wählen Sie das Verzeichnis der Gewichtsdatei | Klicken Sie auf Auswählen. Wählen Sie unter dem Werkzeug DeepClassif die Klassifizierungsparameter (Schwellenwert und Anzahl der Vorhersagen der höchsten Klasse), die Parameter der Führungskarte (Schwellenwert, Alpha, Beta und Farbkarte) und verschiedene Parameter in der Farbkarte aus.

- Zeigen Sie die Ergebnisse des Testbilds an, indem Sie im Debug-Tool auf die Bildfunktion klicken.

- Überprüfen Sie abschließend die vorhergesagten Ergebnisse für jedes Bild, indem Sie auf die Schaltfläche Ausführen im Werkzeug Schaltfläche Ausführen klicken.

8. Hybrid (Detektion und Klassifikation) als Modellversuch

- Um diesen Modelltest durchzuführen, verwenden Sie vier Tools und stellen Sie Verbindungen zwischen ihnen her. Gehen Sie zur Symbolleiste Allgemein | Allgemeines | ButtonRun. Klicken Sie dann auf die Symbolleiste Allgemein | Allgemeines | Debuggen. Danach wird Bild-Symbolleiste | Akquisition | ImageSlide und schließlich Bildsymbolleiste | DeepComposite | DeepD->C.

- Bevor Sie die Bilder testen, gehen Sie folgendermaßen vor: Importieren Sie Testbilder aus dem Bilddateiverzeichnis, indem Sie im Bildfolien-Werkzeug auf die Option Einstellung klicken. Importieren Sie die beiden gespeicherten trainierten Gewichtsdateien aus Abschnitt 2.1.5 und Abschnitt 4.4, indem Sie im DeepD->C-Tool auf die Option Einstellung klicken:

- Klicken Sie für die Detect-Funktion auf die Schaltfläche Config |+ und wählen Sie das Backend (CUDA oder CPU) | Geben Sie einen Namen an | Klicken Sie auf OK | Wählen Sie das Verzeichnis der Gewichtsdatei | Klicken Sie auf Auswählen. Wählen Sie unter der Funktion "Erkennen" die Erkennungsparameter (Schwellenwert und nms), die Zeichnungsparameter, die Tracking-Parameter und die ROI-Parameter aus.

- Klicken Sie für die Classif-Funktion auf die Schaltfläche Config |+ und wählen Sie das Backend (CUDA oder CPU) | Geben Sie einen Namen an | Klicken Sie auf OK | Wählen Sie das Verzeichnis der Gewichtsdatei aus | klicken Sie auf Auswählen. Wählen Sie unter der Funktion "Klassifizieren" die Klassifizierungsparameter (Schwellenwert und Anzahl der Vorhersagen der obersten Klasse) und die Parameter für die Leitlinienzuordnung (Schwellenwert, Alpha, Beta und Farbkarte) aus.

- Zeigen Sie die Ergebnisse des Testbilds an, indem Sie im Debug-Tool auf die Bildfunktion klicken. Überprüfen Sie abschließend die vorhergesagten Ergebnisse für jedes Bild, indem Sie auf die Schaltfläche Ausführen im Werkzeug Schaltfläche Ausführen klicken.

9. Fünffache Kreuzvalidierung

HINWEIS: Um die Leistung des vorgeschlagenen Modells effektiver zu validieren, wird die K-fach-Kreuzvalidierung verwendet.

- Unterteilen Sie den Datensatz in fünf Abschnitte, die den fünf Faltungen der Kreuzvalidierung entsprechen. Verwenden Sie bei jeder Iteration des Modelltrainings und -tests einen Abschnitt als Validierungssatz für Tests und die restlichen vier Abschnitte für das Training. Wiederholen Sie diesen Vorgang fünfmal, wobei jeder Falz einmal als Validierungssatz verwendet wird.

- Für die Falten 1 bis 5:

- Wiederholen Sie Abschnitt 5, um das Modell mit den Trainingsdaten aus den vier Faltungen zu trainieren.

- Wiederholen Sie Abschnitt 7.2, um das Modell mit der verbleibenden Falte als Testsatz zu testen.

10. Evaluierung des Modells

- Konfusions-Matrix

- Basierend auf den Testergebnissen werden die vier Bedingungen wie folgt erfüllt:

- True Positive (TP): Wenn das Eingabebild wahr ist und die Vorhersage ebenfalls wahr ist.

- False Positive (FP): Wenn das Eingabebild falsch ist, die Vorhersage jedoch wahr ist.

- Falsch negativ (FN): Wenn das Eingabebild wahr ist, die Vorhersage jedoch falsch ist.

- Richtig negativ (TN): Wenn das Eingabebild falsch ist und die Vorhersage ebenfalls falsch ist.

- Bewerten Sie anhand dieser vier Bedingungen die Leistung mit der Konfusionsmatrix.

- Basierend auf den Testergebnissen werden die vier Bedingungen wie folgt erfüllt:

- Leistungsbeurteilungen

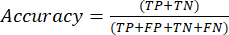

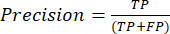

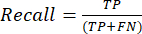

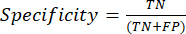

- Die am häufigsten verwendeten Leistungsmetriken für die Klassifizierung sind Genauigkeit, Präzision, Erinnerung, Spezifität und F1-Score-Werte. Berechnen Sie alle Auswertungsmetriken in den Gleichungen (1-6), die zur Bewertung der Modellleistung verwendet werden, aus Werten aus der Konfusionsmatrix.

(1)

(1) (2)

(2) (3)

(3) (4)

(4) (5)

(5) (6)

(6)

- Die am häufigsten verwendeten Leistungsmetriken für die Klassifizierung sind Genauigkeit, Präzision, Erinnerung, Spezifität und F1-Score-Werte. Berechnen Sie alle Auswertungsmetriken in den Gleichungen (1-6), die zur Bewertung der Modellleistung verwendet werden, aus Werten aus der Konfusionsmatrix.

- ROC-Kurve

HINWEIS: Die ROC-Kurve ist ein Leistungsmaß für Klassifizierungsprobleme mit unterschiedlichen Schwellenwerteinstellungen. Die Fläche unter der ROC-Kurve (AUC) stellt den Grad oder das Maß der Trennbarkeit dar, während die ROC eine Wahrscheinlichkeitskurve ist.- Die ROC-Kurve ist ein zweidimensionales Diagramm mit den Werten für die Richtig-Positiv-Rate (TPR) und die Falsch-Positiv-Rate (FPR), die auf der Y- bzw. X-Achse dargestellt sind. Konstruieren Sie die ROC-Kurven mit den TPR- und TFR-Werten, die Sie aus der Konfusionsmatrix erhalten. Der TPR-Wert entspricht der Empfindlichkeit; Berechnen Sie den FPR-Wert mit Hilfe der Gleichung (7).

(7)

(7) - Nachdem Sie die TPR- und FPR-Werte abgerufen haben, zeichnen Sie die ROC-Kurve mit dem Open-Source-Webwerkzeug Jupyter Notebook in einer Python-Umgebung. Die AUC ist eine effektive Methode, um die Leistung des vorgeschlagenen Modells in der ROC-Kurvenanalyse zu bewerten.

- Die ROC-Kurve ist ein zweidimensionales Diagramm mit den Werten für die Richtig-Positiv-Rate (TPR) und die Falsch-Positiv-Rate (FPR), die auf der Y- bzw. X-Achse dargestellt sind. Konstruieren Sie die ROC-Kurven mit den TPR- und TFR-Werten, die Sie aus der Konfusionsmatrix erhalten. Der TPR-Wert entspricht der Empfindlichkeit; Berechnen Sie den FPR-Wert mit Hilfe der Gleichung (7).

- PR-Kurve

- Verwenden Sie die PR-Kurve, um Modelle auszuwerten, indem Sie die Fläche unter der PR-Kurve messen. Konstruieren Sie die PR-Kurve, indem Sie die Genauigkeit und den Abruf der Modelle mithilfe der Konfidenzschwellenwertfunktionen des Modells darstellen. Da es sich bei der PR-Kurve auch um ein zweidimensionales Diagramm handelt, zeichnen Sie Recall auf der x-Achse und Genauigkeit auf der y-Achse.

- Zeichnen Sie die PR-Kurve wie die ROC-Kurve mit dem Open-Source-Webwerkzeug Jupyter Notebook in einer Python-Umgebung. Der Bereich unter der Precision-Recall-Kurve (AUC) ist auch bei der Klassifizierung mit mehreren Bezeichnungen hilfreich.

Ergebnisse

In dieser Studie wurden hybride Deep-Learning-Algorithmen vorgeschlagen, um die Positivität einer Blutprobe mit einer Trypanosomenparasiteninfektion automatisch vorherzusagen. Archivierte, Giemsa-gefärbte Blutausstriche wurden sortiert, um die parasitierten und nicht-parasitären Blutfilme zu lokalisieren und zu klassifizieren, indem der Objekterkennungsalgorithmus verwendet wurde, der auf einem neuronalen Netz des Darknet-Backbones basiert. Innerhalb eines rechteckigen Kastenvorhersageergebnisses, das mit dem vorherig...

Diskussion

Die mikroskopische Beobachtung einer Infektion mit Trypanosoma protozoa wird frühzeitig und häufig eingesetzt, insbesondere bei der Überwachung in abgelegenen Gebieten, in denen es an qualifizierten Technikern mangelt und arbeitsintensive und zeitaufwändige Prozesse die rechtzeitige Meldung an die Gesundheitsorganisation behindern. Obwohl molekularbiologische Techniken wie Immunologie und Polymerase-Kettenreaktion (PCR) als hochempfindliche Methoden zur Unterstützung der Wirksamkeit von Laborbefunden zugelassen wurd...

Offenlegungen

Alle Autoren haben keine finanziellen Offenlegungen und keine Interessenkonflikte.

Danksagungen

Diese Arbeit (Forschungsstipendium für New Scholar, Grant No. RGNS 65 - 212) wurde vom Büro des Staatssekretärs, dem Ministerium für Hochschulbildung, Wissenschaft, Forschung und Innovation (OPS MHESI), der thailändischen Wissenschaftsforschung und Innovation (TSRI) und dem King Mongkut's Institute of Technology Ladkrabang finanziell unterstützt. Wir danken dem National Research Council of Thailand (NRCT) [NRCT5-RSA63001-10] für die Finanzierung des Forschungsprojekts. M.K. wurde vom Thailand Science Research and Innovation Fund Chulalongkorn University finanziert. Wir danken auch dem College of Advanced Manufacturing Innovation, King Mongkut's Institute of Technology, Ladkrabang, die die Deep-Learning-Plattform und Software zur Unterstützung des Forschungsprojekts zur Verfügung gestellt haben.

Materialien

| Name | Company | Catalog Number | Comments |

| Darknet19, Darknet53 and Densenet201 | Gao Huang, Z. L., Laurens van der Maaten. Densely Connected Convolutional Networks. arXiv:1608.06993 [cs.CV]. (2016) | https://github.com/liuzhuang13/DenseNet | Deep convolutional neural network model that can function to classification Generic name: YOLO model/ detection model? |

| Olympus CX31 Model CX31RRBSFA | Olympus, Tokyo, Japan | SN 4G42178 | A light microscope |

| Olympus DP21-SAL U-TV0.5XC-3 | Olympus, Tokyo, Japan | SN 3D03838 | A digital camera Generic name: Classification models/ densely CNNs |

| Window 10 | Microsoft | Window 10 | Operation system in computers |

| YOLO v4-tiny | Naing, K. M. et al. Automatic recognition of parasitic products in stool examination using object detection approach. PeerJ Comput Sci. 8 e1065, (2022). | https://git.cira-lab.com/users/sign_in | Deep convolutional neural network model that can function to both localization and also classification |

| https://git.cira-lab.com/users/sign_in |

Referenzen

- Kasozi, K. I., et al. Epidemiology of trypanosomiasis in wildlife-implications for humans at the wildlife interface in Africa. Frontiers in Veterinary Science. 8, 621699 (2021).

- Ola-Fadunsin, S. D., Gimba, F. I., Abdullah, D. A., Abdullah, F. J. F., Sani, R. A. Molecular prevalence and epidemiology of Trypanosoma evansi among cattle in peninsular Malaysia. Acta Parasitologica. 65 (1), 165-173 (2020).

- Aregawi, W. G., Agga, G. E., Abdi, R. D., Buscher, P. Systematic review and meta-analysis on the global distribution, host range, and prevalence of Trypanosoma evansi. Parasites & Vectors. 12 (1), 67 (2019).

- Joshi, P. P., et al. Human trypanosomiasis caused by Trypanosoma evansi in India: the first case report. The Am Journal of Tropical Medicine and Hygiene. 73 (3), 491-495 (2005).

- Lidani, K. C. F., et al. Chagas disease: from discovery to a worldwide health problem. Frontiers in Public Health. 7, 166 (2019).

- Sazmand, A., Desquesnes, M., Otranto, D. Trypanosoma evansi. Trends in Parasitology. 38 (6), 489-490 (2022).

- Powar, R. M., et al. A rare case of human trypanosomiasis caused by Trypanosoma evansi.Indian. Journal of Medical Microbiology. 24 (1), 72-74 (2006).

- Shegokar, V. R., et al. Short report: Human trypanosomiasis caused by Trypanosoma evansi in a village in India: preliminary serologic survey of the local population. American Journal of Tropical Medicine and Hygiene. 75 (5), 869-870 (2006).

- Haridy, F. M., El-Metwally, M. T., Khalil, H. H., Morsy, T. A. Trypanosoma evansi in dromedary camel: with a case report of zoonosis in greater Cairo, Egypt. Journal of the Egyptian Society of Parasitology. 41 (1), 65-76 (2011).

- Dey, S. K. CATT/T.evansi antibody levels in patients suffering from pyrexia of unknown origin in a tertiary care hospital in Kolkata. Research Journal of Pharmaceutical, Biological and Chemical Sciences. 5, 334-338 (2014).

- Dakshinkar, N. P., et al. Aberrant trypanosomias in human. Royal Veterinary Journal of India. 3 (1), 6-7 (2007).

- Vn Vinh Chau, N., et al. A clinical and epidemiological investigation of the first reported human infection with the zoonotic parasite Trypanosoma evansi in Southeast Asia. Clinical Infectious Diseases. 62 (8), 1002-1008 (2016).

- Misra, K. K., Roy, S., Choudhary, A. Biology of Trypanosoma (Trypanozoon) evansi in experimental heterologous mammalian hosts. Journal of Parasitic Diseases. 40 (3), 1047-1061 (2016).

- Nakayima, J., et al. Molecular epidemiological studies on animal trypanosomiases in Ghana. Parasites & Vectors. 5, 217 (2012).

- Riana, E., et al. The occurrence of Trypanosoma in bats from Western Thailand. The 20th Chulalongkorn University Veterinary Conference CUVC 2021: Research in practice. 51, (2021).

- Camoin, M., et al. The Indirect ELISA Trypanosoma evansi in equids: optimisation and application to a serological survey including racing horses, in Thailand. BioMed Research International. 2019, 2964639 (2019).

- Truc, P., et al. Atypical human infections by animal trypanosomes. PLoS Neglected Tropical Diseases. 7 (9), 2256 (2013).

- Desquesnes, M., et al. Diagnosis of animal trypanosomoses: proper use of current tools and future prospects. Parasites & Vectors. 15 (1), 235 (2022).

- Da Silva, A. S., et al. Trypanocidal activity of human plasma on Trypanosoma evansi in mice. Revista Brasileira de Parasitologia Veterinaria. 21 (1), 55-59 (2012).

- Desquesnes, M., et al. Trypanosoma evansi and surra: a review and perspectives on transmission, epidemiology and control, impact, and zoonotic aspects. BioMed Research International. 2013, 321237 (2013).

- World Health Organization. A new form of human trypanosomiasis in India. Description of the first human case in the world caused by Trypanosoma evansi. Weekly Epidemiological Record. 80 (7), 62-63 (2005).

- Naing, K. M., et al. Automatic recognition of parasitic products in stool examination using object detection approach. PeerJ Computer Science. 8, 1065 (2022).

- Wongsrichanalai, C., Barcus, M. J., Muth, S., Sutamihardja, A., Wernsdorfer, W. H. A review of malaria diagnostic tools: microscopy and rapid diagnostic test (RDT). American Journal of Tropical Medicine and Hygiene. 77, 119-127 (2007).

- Rostami, A., Karanis, P., Fallahi, S. Advances in serological, imaging techniques and molecular diagnosis of Toxoplasma gondii infection. Infection. 46 (3), 303-315 (2018).

- Ahmad, Z., Rahim, S., Zubair, M., Abdul-Ghafar, J. Artificial intelligence (AI) in medicine, current applications and future role with special emphasis on its potential and promise in pathology: present and future impact, obstacles including costs and acceptance among pathologists, practical and philosophical considerations. A comprehensive review. Diagnostic Pathology. 16 (1), 24 (2021).

- Sarker, I. H. Deep learning: a comprehensive overview on techniques, taxonomy, applications and research directions. SN Computer Science. 2 (6), 420 (2021).

- Kittichai, V., et al. Classification for avian malaria parasite Plasmodium gallinaceum blood stages by using deep convolutional neural networks. Scientific Reports. 11 (1), 16919 (2021).

- Baskota, S. U., Wiley, C., Pantanowitz, L. The next generation robotic microscopy for intraoperative teleneuropathology consultation. Journal of Pathology Informatics. 11, 13 (2020).

- Bochkovskiy, A., Wang, C. -. Y., Liao, H. -. Y. M. YOLOv4: optimal speed and accuracy of object detection. arXiv. , 10934 (2004).

- Huang, G., Liu, Z., vander Maaten, L., Weinberger, K. Q. Densely connected convolutional networks. arXiv. , 06993 (2018).

- . CDC-DPDx. Diagnostic procedures - Blood specimens Available from: https://www.cdc.gov/dpdx/diagosticprocedures/blood/specimenproc.html#print (2020)

- Control and surveillance of African trypanosomiasis: report of a WHO expert committee. WHO Technical Report Series 881 Available from: https://iris.who.int/bitstream/handle/10665/42087/WHO_TRS_881.pdf?sequence=1 (1998)

- Leber, A. L. Detection of blood parasites. Clinical Microbiology Procedures Handbook. , (2022).

- Huang, L. -. P., Hong, M. -. H., Luo, C. -. H., Mahajan, S., Chen, L. -. J. A vector mosquitoes classification system based on edge computing and deep learning. Proceedings-2018 Conmference on Technologies and Applications of Artifical Intelligence. , 24-27 (2018).

- Cihan, P., Gökçe, E., Kalipsiz, O. A review of machine learning applications in veterinary field. Kafkas Universitesi Veteriner Fakultesi Dergisi. 23 (4), 673-680 (2017).

- Berrar, D. Cross-validation. Encyclopedia of Bioinformatics and Computational Biology. 1, 542-545 (2019).

- Gaithuma, A. K., et al. A single test approach for accurate and sensitive detection and taxonomic characterization of Trypanosomes by comprehensive analysis of internal transcribed spacer 1 amplicons. PLoS Neglected Tropical Diseases. 13 (2), 0006842 (2019).

- Vijayalakshmi, A., Rajesh Kanna, B. Deep learning approach to detect malaria from microscopic images. Multimedia Tools and Applications. 79 (21-22), 15297-15317 (2019).

- Morais, M. C. C., et al. Automatic detection of the parasite Trypanosoma cruzi in blood smears using a machine learning approach applied to mobile phone images. PeerJ. 10, 13470 (2022).

- Uc-Cetina, V., Brito-Loeza, C., Ruiz-Pina, H. Chagas parasite detection in blood images using AdaBoost. Computational and Mathematical Methods in Medicine. 2015, 139681 (2015).

- Zhang, C., et al. Deep learning for microscopic examination of protozoan parasites. Computational and Structural Biotechnology Journal. 20, 1036-1043 (2022).

- Sarataphan, N., et al. Diagnosis of a Trypanosoma lewisi-like (Herpetosoma) infection in a sick infant from Thailand. Journal of Medical Microbiology. 56, 1118-1121 (2007).

- Desquesnes, M., et al. A review on the diagnosis of animal trypanosomoses. Parasites & Vectors. 15 (1), 64 (2022).

- Fuhad, K. M. F., et al. Deep learning based automatic malaria parasite detection from blood smear and its smartphone based application. Diagnostics (Basel). 10 (5), 329 (2020).

- Christian Matek, S. S., Spiekermann, K., Marr, C. Human-level recognition of blast cells in acute myeloid leukaemia with convolutional neural networks. Nature Machine Intelligence. 1, 538-544 (2019).

- Hamdan, S., Ayyash, M., Almajali, S. Edge-computing architectures for internet of things applications: a survey. Sensors (Basel). 20 (22), 6441 (2020).

- Visser, T., et al. A comparative evaluation of mobile medical APPS (MMAS) for reading and interpreting malaria rapid diagnostic tests. Malaria Journal. 20 (1), 39 (2021).

- Giorgi, E., Macharia, P. M., Woodmansey, J., Snow, R. W., Rowlingson, B. Maplaria: a user friendly web-application for spatio-temporal malaria prevalence mapping. Malaria Journal. 20 (1), 471 (2021).

- Rajaraman, S., Jaeger, S., Antani, S. K. Performance evaluation of deep neural ensembles toward malaria parasite detection in thin-blood smear images. PeerJ. 7, 6977 (2019).

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenWeitere Artikel entdecken

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten