Zum Anzeigen dieser Inhalte ist ein JoVE-Abonnement erforderlich. Melden Sie sich an oder starten Sie Ihre kostenlose Testversion.

Method Article

Bodennahe Bilder von unbemannten Flugsystemen in Verbindung mit räumlich ausgewogener Probenahme und Routenoptimierung zur Überwachung der Weidelandvegetation

In diesem Artikel

Zusammenfassung

Das in diesem Artikel vorgestellte Protokoll nutzt Routenoptimierung, ausgewogene Akzeptanzstichproben sowie Bilder von bodennahen und unbemannten Flugzeugsystemen (UAS), um die Vegetation in Weideland-Ökosystemen effizient zu überwachen. Es werden Ergebnisse von Bildern verglichen, die mit bodennahen und UAS-Methoden aufgenommen wurden.

Zusammenfassung

Weideland-Ökosysteme bedecken weltweit 3,6 Milliarden Hektar, davon 239 Millionen Hektar in den Vereinigten Staaten. Diese Ökosysteme sind entscheidend für die Aufrechterhaltung der globalen Ökosystemleistungen. Die Überwachung der Vegetation in diesen Ökosystemen ist erforderlich, um die Gesundheit des Weidelandes zu beurteilen, die Eignung von Lebensräumen für Wildtiere und Haustiere zu beurteilen, invasive Unkräuter zu bekämpfen und zeitliche Umweltveränderungen aufzuklären. Obwohl Weideland-Ökosysteme große Gebiete abdecken, sind traditionelle Überwachungstechniken oft zeitaufwändig und kostenineffizient, unterliegen einer starken Verzerrung durch Beobachter und verfügen oft über unzureichende räumliche Informationen. Die bildbasierte Vegetationsüberwachung ist schneller, erzeugt dauerhafte Aufzeichnungen (d. h. Bilder), kann zu einer geringeren Verzerrung des Beobachters führen und enthält von Natur aus angemessene räumliche Informationen. Räumlich ausgewogene Probenahmedesigns sind bei der Überwachung natürlicher Ressourcen von Vorteil. Es wird ein Protokoll für die Implementierung eines räumlich ausgewogenen Probenahmedesigns vorgestellt, das als Balanced Acceptance Sampling (BAS) bekannt ist, mit Bildern, die von Bodenkameras und unbemannten Flugsystemen (UAS) aufgenommen wurden. Zur Lösung des "Traveling Salesperson Problems" (TSP) wird zusätzlich ein Routenoptimierungsalgorithmus eingesetzt, um die Zeit- und Kosteneffizienz zu steigern. Während UAS-Bilder 2- bis 3x schneller aufgenommen werden können als Handheld-Bilder, ähneln sich beide Arten von Bildern in Bezug auf Genauigkeit und Präzision. Abschließend werden die Vor- und Nachteile der einzelnen Methoden diskutiert und Beispiele für mögliche Anwendungen dieser Methoden in anderen Ökosystemen vorgestellt.

Einleitung

Weideland-Ökosysteme erstrecken sich über riesige Flächen, die in den Vereinigten Staaten 239 Millionen Hektar und weltweit 3,6 Milliarden Hektar umfassen1. Weideland bietet eine breite Palette von Ökosystemdienstleistungen, und die Bewirtschaftung von Weideland umfasst mehrere Landnutzungen. Im Westen der USA bieten Weideland Lebensraum für Wildtiere, Wasserspeicherung, Kohlenstoffbindung und Futter für heimisches Vieh2. Weideland ist verschiedenen Störungen ausgesetzt, darunter invasive Arten, Waldbrände, Infrastrukturentwicklung und die Gewinnung natürlicher Ressourcen (z. B. Öl, Gas und Kohle)3. Die Überwachung der Vegetation ist entscheidend für die Aufrechterhaltung des Ressourcenmanagements in Weideland und anderen Ökosystemen auf der ganzen Welt 4,5,6. Die Vegetationsüberwachung in Weideland wird häufig eingesetzt, um die Gesundheit des Weidelandes und die Eignung von Lebensräumen für Wildtierarten zu beurteilen und Veränderungen in Landschaften aufgrund invasiver Arten, Waldbrände und der Ausbeutung natürlicher Ressourcen zu katalogisieren 7,8,9,10. Während die Ziele bestimmter Überwachungsprogramme variieren können, sind Überwachungsprogramme erwünscht, die den Bedürfnissen mehrerer Interessengruppen entsprechen und gleichzeitig statistisch zuverlässig, wiederholbar und wirtschaftlich sind 5,7,11. Obwohl die Landbewirtschafter die Bedeutung der Überwachung anerkennen, wird sie oft als unwissenschaftlich, unwirtschaftlich und belastend angesehen5.

Traditionell wird die Überwachung von Weideland mit einer Vielzahl von Methoden durchgeführt, darunter die okuläre oder visuelle Schätzung10, Daubenmire-Rahmen12, die Plot-Kartierung13 und der Linienpunkt-Schnitt entlang der Vegetationstransekte14. Die okuläre oder visuelle Schätzung ist zwar zeiteffizient, unterliegt jedoch einer hohen Beobachterverzerrung15. Andere traditionelle Methoden unterliegen zwar ebenfalls einer hohen Beobachterverzerrung, sind aber aufgrund ihres Zeit- und Kostenaufwands oft ineffizient 6,15,16,17. Der Zeitaufwand für die Implementierung vieler dieser traditionellen Methoden ist oft zu aufwendig, was es schwierig macht, statistisch valide Stichprobengrößen zu erhalten, was zu unzuverlässigen Schätzungen der Grundgesamtheit führt. Diese Methoden werden oft aus Bequemlichkeit und nicht stochastisch angewendet, wobei die Beobachter selbst entscheiden, wo sie Daten sammeln. Darüber hinaus unterscheiden sich die gemeldeten und tatsächlichen Probenstandorte häufig, was bei Landbewirtschaftern und anderen Interessengruppen, die auf Vegetationsüberwachungsdaten angewiesen sind, zu Verwirrung führt18. Jüngste Forschungen haben gezeigt, dass bildbasiertes Vegetationsmonitoring zeit- und kosteneffizient ist 6,19,20. Die Erhöhung der Datenmenge, die innerhalb eines bestimmten Gebiets in kurzer Zeit erfasst werden kann, sollte die statistische Zuverlässigkeit der Daten im Vergleich zu zeitaufwändigeren herkömmlichen Techniken verbessern. Bilder sind permanente Aufzeichnungen, die von mehreren Beobachtern analysiert werden können, nachdem Felddaten gesammelt wurden6. Darüber hinaus sind viele Kameras mit einem globalen Positionierungssystem (GPS) ausgestattet, so dass Bilder mit einem Sammelort 18,20 getaggt werden können. Die Verwendung von computergenerierten Probenahmepunkten, die genau im Feld lokalisiert werden, sollte die Verzerrung des Beobachters verringern, unabhängig davon, ob das Bild mit einer Handkamera oder von einem unbemannten Flugsystem aufgenommen wurde, da es die Neigung eines einzelnen Beobachters verringert, seine Meinung darüber zu äußern, wo die Probenorte platziert werden sollten.

Abgesehen davon, dass es zeitaufwändig und kostspielig ist und einer hohen Verzerrung durch die Beobachter unterliegt, gelingt es der traditionellen Überwachung natürlicher Ressourcen aufgrund der geringen Stichprobengröße und der konzentrierten Probenahmeorte häufig nicht, heterogenes Weideland angemessen zu charakterisieren21. Räumlich ausgewogene Probenahmedesigns verteilen die Probenstandorte gleichmäßiger über ein interessierendes Gebiet, um die natürlichen Ressourcen besser zu charakterisieren 21,22,23,24. Diese Designs können die Stichprobenkosten senken, da kleinere Stichprobengrößen erforderlich sind, um statistische Genauigkeit im Vergleich zu einfachen Zufallsstichprobenzu erreichen 25.

Bei dieser Methode wird ein räumlich ausgewogenes Stichprobendesign, das als Balanced Acceptance Sampling (BAS)22,24 bekannt ist, mit einem bildbasierten Monitoring kombiniert, um die Vegetation des Weidelandes zu beurteilen. BAS-Punkte sind optimal über den Interessenbereich26 verteilt. Dies garantiert jedoch nicht, dass die Punkte auf einer optimalen Route für den Besuch20 bestellt werden. Daher werden BAS-Punkte mithilfe eines Routenoptimierungsalgorithmus angeordnet, der das Problem des Handlungsreisenden (TSP)27 löst. Wenn Sie die Punkte in dieser Reihenfolge besuchen, wird ein optimaler Pfad (d. h. die geringste Entfernung) ermittelt, der die Punkte verbindet. BAS-Punkte werden in ein Softwareprogramm für ein geographisches Informationssystem (GIS) und dann in ein tragbares Datenerfassungsgerät übertragen, das mit GPS ausgestattet ist. Nachdem die BAS-Punkte lokalisiert wurden, werden Bilder mit einer GPS-fähigen Kamera sowie einem unbemannten Flugsystem aufgenommen, das mit Hilfe einer Flugsoftware gesteuert wird. Beim Betreten des Feldes geht ein Techniker zu jedem Punkt, um Bilder von 1 m2 Einbeinstativkameras mit einem Bodenabtastabstand (GSD) von 0,3 mm an jedem BAS-Punkt aufzunehmen, während ein UAS zu denselben Punkten fliegt und 2,4 mm-GSD-Bilder aufnimmt. Anschließend werden mit 'SamplePoint'28 Daten zur Vegetationsbedeckung generiert, um 36 Punkte/Bild manuell zu klassifizieren. Die Daten zur Vegetationsbedeckung, die aus der Analyse von Boden- und UAS-Bildern generiert wurden, werden verglichen und die Erfassungszeiten für jede Methode angegeben. In der repräsentativen Studie wurden zwei benachbarte, 10 Hektar große Weideflächen verwendet. Schließlich werden weitere Anwendungen dieser Methode diskutiert und wie sie für zukünftige Projekte oder Projekte in anderen Ökosystemen modifiziert werden kann.

Access restricted. Please log in or start a trial to view this content.

Protokoll

1. Definition des Untersuchungsbereichs, Generierung von Probenahmepunkten und Reisepfad sowie Feldvorbereitung

- Definition des Studienbereichs

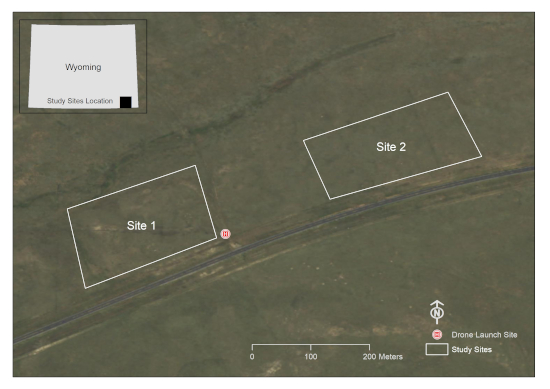

- Verwenden Sie ein GIS-Softwareprogramm, um eine oder mehrere Polygongrafiken um die relevanten Bereiche zu zeichnen. Diese Studie wurde auf zwei 10 Hektar großen Parzellen in einem Weidegarten in Laramie County, WY, USA durchgeführt (Abbildung 1).

- Stellen Sie sicher, dass die Bereiche, die nicht innerhalb des Beispielrahmens liegen sollen, aus dem Polygon ausgeschlossen werden (z. B. Gewässer, Gebäudestrukturen, Straßen usw.). Dadurch wird sichergestellt, dass später keine Bilder von diesen Bereichen gemacht werden.

- Konvertieren Sie die Polygongrafik im GIS-Softwareprogramm in ein Shapefile-Feature (.shp), und stellen Sie sicher, dass das Shapefile im gewünschten Koordinatensystem erstellt wird.

Abbildung 1: Eine Darstellung der Untersuchungsgebiete. Dieser Standort befindet sich auf einem Weidegarten südlich von Cheyenne in Laramie County, WY, USA (Bildquelle: Wyoming NAIP Imagery 2017). Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

- Generierung der BAS-Punkte und Optimierung des Fahrweges

HINWEIS: Der Code wird als "Supplemental_Code.docx" angehängt.- Verwenden Sie das R-Paket 'rgdal'29 , um das GIS-Polygon in eine von Program R lesbare Datei zu konvertieren.

- Verwenden Sie das R-Paket 'SDraw'30 , um die gewünschte Anzahl an BAS-Punkten zu generieren. In dieser Studie wurden 30 BAS-Punkte pro Untersuchungsgebiet verwendet, obwohl zukünftige Untersuchungen durchgeführt werden sollten, um die optimale Probenahmeintensität für Gebiete unterschiedlicher Größe und Vegetationszusammensetzung zu bestimmen.

- Verwenden Sie das R-Paket 'TSP'27 , um die BAS-Punkte zu bestellen. Der Besuch der Punkte in dieser Reihenfolge minimiert den Zeitaufwand für die Entnahme von Proben an den BAS-Punkten.

- Vorbereitung für die Aufnahme von Handheld-Bildern

- Verwenden Sie das R-Paket 'rgdal', um die Punkte aus Schritt 1.2.1 zurück in das GIS-Programm zu übertragen.

- Bearbeiten Sie die Attributtabelle des Shapefiles so, dass das Punkt-ID-Feld die optimierte Pfadreihenfolge genau wiedergibt.

- Übertragen Sie das GIS-Polygon und die Punktdatei in die GIS-Software, die auf einem Handheld-Gerät ausgeführt wird.

- Stellen Sie sicher, dass das richtige projizierte Koordinatensystem für den Interessenbereich vorhanden ist.

- Vorbereitung für die UAS-Bildaufnahme

- Verwenden Sie das R-Paket 'rgdal', um die Punkte aus Schritt 1.2.1 zurück in das GIS-Softwareprogramm zu übertragen.

- Verwenden Sie im GIS-Softwareprogramm das Werkzeug XY-Koordinaten hinzufügen , um Breiten- und Längengradfelder in der Wegpunktattributtabelle zu erstellen und auszufüllen.

- Exportieren Sie die Wegpunktattributtabelle mit den Spalten Breitengrad, Längengrad und TSP in das Dateiformat *.csv.

- Öffnen Sie die *.csv-Datei in einem geeigneten Softwarepaket.

- Sortieren Sie Wegpunkte nach TSP-Kennung.

- Öffnen Sie die Mission Hub-App.

- Erstellen Sie einen beliebigen Wegpunkt im Mission Hub.

- Exportieren Sie beliebige Wegpunkte als *.csv Datei.

- Öffnen Sie die *.csv-Datei in einem Tabellenkalkulationsprogramm und löschen Sie beliebige Wegpunkt-Spaltenüberschriften.

- Kopieren Sie TSP-sortierte Wegpunkt-Koordinatenpaare aus Schritt 1.2.3 in die entsprechenden Spalten in der *.csv Datei aus Schritt 1.4.8.

- Importieren Sie eine *.csv-Datei aus Schritt 1.4.10 als neue Mission in den Missionshub.

- Definieren Sie die Einstellungen.

- Aktivieren Sie das Kontrollkästchen Online-Höhe verwenden .

- Geben Sie den Pfadmodus als Gerade Linien an.

- Geben Sie Finish-Aktion als RTH an, damit die Drohne nach Abschluss der Mission nach Hause zurückkehren kann.

- Klicken Sie auf einzelne Wegpunkte und Aktionen hinzufügen , indem Sie die folgenden Parameter angeben: Aufenthalt: 2 s (um Bildunschärfe zu vermeiden); Neigung der Kamera: -90° (Nadir); Foto machen.

- Speichern Sie die Mission mit einem passenden Namen.

- Wiederholen Sie den Vorgang für weitere Standorte.

2. Felddatenerfassung und Nachbearbeitung

- Erfassung der im Untersuchungsgebiet beobachteten oder erwarteten Vegetation

- Erstellen Sie vor der Aufnahme von Bildern eine Liste der im Untersuchungsgebiet beobachteten Vegetation. Dies kann auf einem handschriftlichen Blatt oder auf einem digitalen Formular erfolgen, um die spätere Lichtbildidentifikation zu erleichtern. Es kann von Vorteil sein, Arten, die wahrscheinlich in dem Gebiet zu erwarten sind, in das Inventar aufzunehmen, auch wenn sie nicht auf dem Feld beobachtet werden (z. B. Arten in Rekultivierungssaatgutmischungen)18.

- Bodengestützte Bilderfassung

- Befestigen Sie eine Kamera an einem vertikalen Einbeinstativ und richten Sie die Kamera ca. 60° nach unten. Der Bildbereich kann anhand der Objektiv- und Auflösungsspezifikationen (Megapixel) der Kamera und der Einstellung des Einbeinstativs auf eine Standardhöhe bestimmt werden. Die Höhe des Einbeinstativs in Verbindung mit den Kameraspezifikationen bestimmt den Bodenabtastabstand (GSD). In dieser Studie wurde eine 12,1-Megapixel-Kamera verwendet und das Einbeinstativ in einem konstanten Abstand von 1,3 m über dem Boden eingestellt, um Nadir-Bilder bei ~0,3 mm GSD18 zu erhalten.

- Neigen Sie das Einbeinstativ nach vorne, sodass sich das Kameraobjektiv in einer Nadir-Position befindet und das abgewinkelte Einbeinstativ auf dem Bild nicht sichtbar ist.

- Passen Sie die Höhe des Einbeinstativs oder den Zoom am Objektiv an, um eine rahmenlose Plotgröße von 1 m2 (oder eine andere gewünschte Plotgröße) zu erreichen. Bei den gebräuchlichsten Kameras mit einem Seitenverhältnis von 4:3 ergibt sich bei einer Plotbreite von 115 cm ein Bildsichtfeld von 1 m2 . Es ist nicht erforderlich, einen Rahmen auf den Boden zu stellen; Das gesamte Bild ist die Handlung. Wenn Sie den Zoom am Objektiv anpassen, um dies zu erreichen, verwenden Sie Malerband, um versehentliche Änderungen der Zoomeinstellung zu verhindern.

- Wenn möglich, stellen Sie die Kamera auf Verschlusszeit und stellen Sie die Verschlusszeit auf mindestens 1/125 s ein, um Unschärfen im Bild zu vermeiden. Schneller, wenn es windig ist.

- Lokalisieren Sie den ersten Punkt in der optimierten Pfadreihenfolge.

- Platzieren Sie das Einbeinstativ an Punkt 1 auf dem Boden und neigen Sie das Einbeinstativ, bis sich die Kamera in Nadir-Ausrichtung befindet. Stellen Sie sicher, dass sich der Schatten des Operators nicht im Bild befindet. Halten Sie die Kamera ruhig, um Bewegungsunschärfe zu vermeiden. Erfassen Sie das Bild.

HINWEIS: Für diesen Schritt ist ein Kabel für den Fernauslöser nützlich. - Überprüfen Sie die Bildqualität, um eine erfolgreiche Datenerfassung zu gewährleisten.

- Navigieren Sie zum nächsten Punkt in der optimierten Pfadreihenfolge und wiederholen Sie die Erfassungsschritte.

- UAS-Bilderfassung

- Führen Sie vor dem Start des UAS eine kurze Erkundung des Untersuchungsgebiets durch, um sicherzustellen, dass sich keine physischen Hindernisse innerhalb der Flugbahn befinden. Diese Aufklärungsübung ist auch nützlich, um ein relativ flaches Gebiet zu lokalisieren, von dem aus das UAS gestartet werden kann.

- Stellen Sie sicher, dass die Wetterbedingungen für das Fliegen des UAS geeignet sind: ein trockener, klarer Tag (>4,8 km Sichtweite) mit ausreichender Beleuchtung, minimalem Wind (<17 Knoten) und Temperaturen zwischen 0 °C und 37 °C.

- Befolgen Sie die gesetzlichen Protokolle. In den USA sollten beispielsweise die Richtlinien der Federal Aviation Administration befolgt werden.

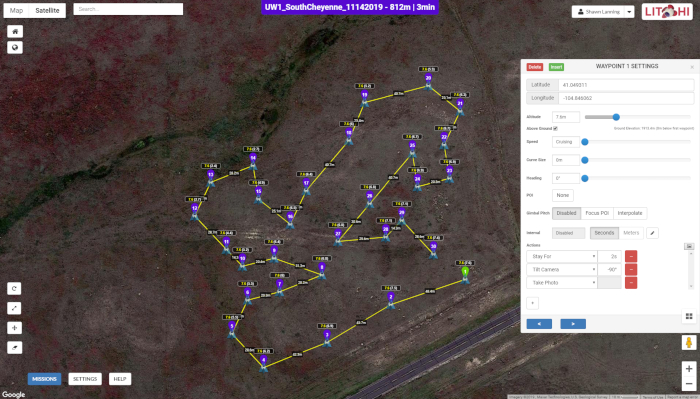

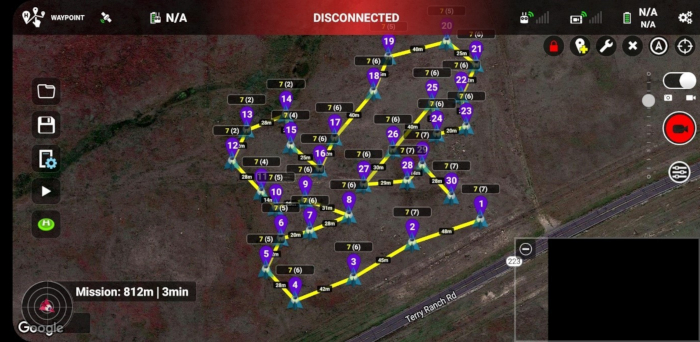

- Verwenden Sie die Mission Hub-Software (Abbildung 2) und eine Anwendung zur Missionsausführung, auf die über mobile Geräte zugegriffen werden kann (Abbildung 3).

- Erfassen Sie UAS-Bilder an jedem BAS-Punkt, wie in Schritt 1.4 beschrieben.

- Stellen Sie sicher, dass alle Bilder mit dem Mobilgerät erfasst wurden, bevor Sie den Standort gewechselt haben.

Abbildung 2: Die Benutzeroberfläche von Mission Hub. Die Karte zeigt die Flugbahn der Drohne entlang einer Reihe von 30 BAS-Punkten an einem der Untersuchungsstandorte, während das Popup-Fenster die Bildaufnahmeparameter an jedem Wegpunkt anzeigt. Abbildung 2 ist spezifisch für Standort 1, obwohl sie in ihrer Darstellung Standort 2 ähnelt. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Abbildung 3: Die Wegpunkt-Flugmission in der Missionsausführungsanwendung von Litchi, die auf einem Android-Smartphone ausgeführt wird. Eindeutige Wegpunkt-IDs werden violett dargestellt und stellen die relative Reihenfolge dar, in der Bilder an verschiedenen Punkten im Untersuchungsgebiet aufgenommen wurden. Die Zahlen an jedem Wegpunkt, z. B. 7(6), geben die ganzzahligen Werte der Höhen über dem Boden, bei denen die Bilder aufgenommen wurden (erste Zahl), und der Höhen über dem Startpunkt oder dem Drohnenstartplatz (zweite Zahl) an. Beachten Sie die Entfernungen zwischen aufeinanderfolgenden Wegpunkten, die auf der Karte beschriftet sind. Abbildung 3 ist spezifisch für Standort 1, obwohl sie in ihrer Darstellung Standort 2 ähnelt. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

- Nachbearbeitung von Bildern in Bodennähe.

HINWEIS: Eine Anleitung finden Sie unter www.SamplePoint.org im Tutorial-Bereich. Eine ergänzende .pdf Datei ist beigefügt.- Laden Sie Bilder mit einem USB-Kabel oder einer SD-Karte auf einen Computer herunter.

- Stellen Sie sicher, dass die Bilder an den richtigen Orten aufgenommen wurden. Es gibt verschiedene Software, um Bilder basierend auf den Metadaten in den geogetaggten Bildern in der GIS-Software zu platzieren.

- Wenn die Bilder in mehreren Untersuchungsbereichen aufgenommen wurden, speichern Sie sie für die Bildanalyse in separaten Ordnern.

- UAS-Bildnachbearbeitung

- Übertragen Sie Bilder, die auf einer austauschbaren microSD-Karte gespeichert sind, vom UAS auf den Computer.

- Wiederholen Sie die Schritte 2.4.2 und 2.4.3.

3. Bildanalyse

HINWEIS: Alle Schritte finden Sie im Abschnitt "Tutorial" auf www.SamplePoint.org; Eine ergänzende Datei "tutorial.pdf" ist beigefügt.

- Klicken Sie in SamplePoint auf Optionen | Datenbank-Assistent | Datenbank erstellen/füllen.

- Benennen Sie die Datenbank basierend auf dem Untersuchungsgebiet.

- Navigieren Sie zu dem Ordner, der die gewünschten Untersuchungsgebietsproben enthält, und wählen Sie die zu klassifizierenden Proben aus.

- Klicken Sie auf Fertig.

- Klicken Sie auf Optionen | Wählen Sie Datenbank aus , und wählen Sie die *.xls Datei aus, die SamplePoint basierend auf der Bildauswahl generiert (diese befindet sich im Bild).

- Vergewissern Sie sich, dass die richtige Anzahl von Bildern in der Datenbank ausgewählt wurde, wenn Sie von SamplePoint dazu aufgefordert werden.

- Wählen Sie die gewünschte Anzahl von Pixeln aus, die in jedem Bild analysiert werden sollen. Dies kann in einem Rastermuster oder nach dem Zufallsprinzip erfolgen. In dieser Studie wurde ein 6 x 6-Raster verwendet, um insgesamt 36 Pixel auszuwählen, obwohl je nach gewünschter Messgenauigkeit für die Klassifizierung mehr oder weniger Pixel pro Bild klassifiziert werden können. Eine kürzlich durchgeführte Studie ergab, dass 20 bis 30 Pixel pro Bild für die Bemusterung großer Flächen ausreichen31. Die Rasteroption stellt sicher, dass sich die Pixel an der gleichen Position befinden, wenn das Bild erneut analysiert wird, während die Zufallsoption jedes Mal, wenn ein Bild neu geladen wird, zufällig Pixel generiert.

- Erstellen Sie eine benutzerdefinierte Button-Datei für die Klassifizierung von Arten. Diese Liste kann aus der Vegetationsliste erstellt werden, die vor der Bildaufnahme vor Ort aufgenommen wurde, oder sie kann auf anderen Informationen basieren, die für das Untersuchungsgebiet relevant sind (z. B. Liste der Saatgutmischungen auf zurückgewonnenen Standorten oder Informationen zur Beschreibung des ökologischen Standorts usw.). Stellen Sie sicher, dass eine Schaltfläche für "Nackter Boden" oder "Boden" und andere potenzielle Nichtvegetationsgegenstände erstellt wurde, die möglicherweise angetroffen werden, wie z. B. Müll oder Stein. Es wird empfohlen, die Schaltfläche Unbekannt zu erstellen, damit der Analyst die Arten zu einem späteren Zeitpunkt klassifizieren kann. Das Kommentarfeld in SamplePoint kann verwendet werden, um die Pixel zu notieren, für die diese Option verwendet wurde. Wenn die Bildauflösung nicht hoch genug ist, um sie auf Artenebene zu klassifizieren, ist das Erstellen von Schaltflächen für funktionelle Gruppen (z. B. Gras, Kräuter, Strauch) von Vorteil.

- Beginnen Sie mit der Analyse der Bilder, indem Sie auf die Klassifizierungsschaltfläche klicken, die das Bildpixel beschreibt, auf das das rote Fadenkreuz abzielt. Wiederholen Sie diesen Vorgang, bis SamplePoint die Meldung "Das sind alle Punkte. Klicken Sie auf das nächste Bild." Wiederholen Sie diesen Vorgang für alle Bilder in der Datenbank.

HINWEIS: Die Zoom-Funktion kann verwendet werden, um die Klassifizierung zu unterstützen. - Wenn alle Bilder in der Datenbank vollständig analysiert sind, gibt SamplePoint die Meldung "Sie haben alle Bilder erschöpft" an. Wählen Sie an dieser Stelle OK aus, und klicken Sie dann auf Optionen | Erstellen Sie Statistikdateien.

- Wechseln Sie zu dem Ordner, in dem sich die Datenbank befindet, und öffnen Sie die soeben erstellte *.csv Datei, um sicherzustellen, dass die Daten für alle Bilder gespeichert werden.

4. Statistische Auswertung

- Chi-Quadrat-Analysen zur Bestimmung von Unterschieden zwischen Standorten

- Da an beiden Standorten die gleiche Anzahl von Bildern (primäre Abtasteinheiten) und Pixel (sekundäre Abtasteinheiten) gesammelt und analysiert werden, kann der Vergleich zwischen den beiden Standorten als Produkt des multinomialen Designs betrachtet werden.

- Berechnen Sie mit der in Schritt 3.11 erstellten Datei *.csv die Summe der klassifizierten Punkte für jede Klassifizierungskategorie.

- Führen Sie eine Chi-Quadrat-Analyse für die Punktsummen durch. Wenn Seite 1 und Seite 2 einander ähnlich sind, wird eine ungefähr gleiche Anzahl von Pixeln, die als jeder Covertyp klassifiziert sind, auf beiden Seiten18 offensichtlich sein.

- Regression zum Vergleich von UAS- und bodennahen Bildern

- Kopieren Sie mit den in Schritt 3.11 erstellten *.csv-Dateien das durchschnittliche prozentuale Cover jedes Bildes, fügen Sie es ein und richten Sie die UAS-Bilddaten an den ebenerdigen Bilddaten aus.

- Führen Sie eine Regressionsanalyse in einem Datenbankprogramm durch.

Access restricted. Please log in or start a trial to view this content.

Ergebnisse

Die UAS-Bilderfassung nahm weniger als die Hälfte der Zeit in Anspruch wie die bodengestützte Bildaufnahme, während die Analysezeit bei bodengestützten Bildern etwas geringer war (Tabelle 1). Bodengestützte Bilder hatten eine höhere Auflösung, was wahrscheinlich der Grund dafür ist, dass sie in kürzerer Zeit analysiert wurden. Unterschiede in der Gehzeit zwischen den Standorten waren wahrscheinlich darauf zurückzuführen, dass Start- und Endpunkte (Startplatz) ...

Access restricted. Please log in or start a trial to view this content.

Diskussion

Die Bedeutung der Überwachung natürlicher Ressourcen ist seit langem anerkannt14. Mit zunehmender Aufmerksamkeit für globale Umweltprobleme wird die Entwicklung zuverlässiger Überwachungstechniken, die zeit- und kosteneffizient sind, immer wichtiger. Mehrere frühere Studien haben gezeigt, dass die Bildanalyse im Vergleich zu herkömmlichen Vegetationsüberwachungstechniken in Bezug auf Zeit, Kosten und die Bereitstellung gültiger und vertretbarer statistisc...

Access restricted. Please log in or start a trial to view this content.

Offenlegungen

Die Autoren erklären, dass kein Interessenkonflikt besteht. Die in dieser Studie verwendete Software stand den Autoren entweder als Open Source oder über institutionelle Genehmigungen zur Verfügung. Kein Autor wird von einer in dieser Studie verwendeten Software gesponsert und erkennt an, dass andere Softwareprogramme verfügbar sind, die in der Lage sind, ähnliche Forschungen durchzuführen.

Danksagungen

Diese Forschung wurde mehrheitlich vom Wyoming Reclamation and Restoration Center und Jonah Energy, LLC finanziert. Wir danken Warren Resources und Escelara Resources für die Finanzierung des Trimble Juno 5. Wir danken Jonah Energy, LLC für die kontinuierliche Unterstützung bei der Finanzierung des Vegetationsmonitorings in Wyoming. Wir danken dem Wyoming Geographic Information Science Center für die Bereitstellung der UAS-Ausrüstung, die in dieser Studie verwendet wurde.

Access restricted. Please log in or start a trial to view this content.

Materialien

| Name | Company | Catalog Number | Comments |

| ArcGIS | ESRI | GPS Software | |

| DJI Phantom 4 Pro | DJI | UAS | |

| G700SE | Ricoh | GPS-equipped camera | |

| GeoJot+Core | Geospatial Experts | GPS Software | Used to extract image metadata |

| Juno 5 | Trimble | Handheld GPS device | |

| Litchi Mission Hub | Litchi | Mission Hub Software | We chose Litchi for its terrain awareness and its ability to plan robust waypoint missions |

| Program R | R Project | Statistical analysis/programming software | |

| SamplePoint | N/A | Image analysis software |

Referenzen

- Follett, R. F., Reed, D. A. Soil carbon sequestration in grazing lands: societal benefits and policy implications. Rangeland Ecology & Management. 63, 4-15 (2010).

- Ritten, J. P., Bastian, C. T., Rashford, B. S. Profitability of carbon sequestration in western rangelands of the United States. Rangeland Ecology & Management. 65, 340-350 (2012).

- Stahl, P. D., Curran, M. F. Collaborative efforts towards ecological habitat restoration of a threatened species, Greater Sage-grouse, in Wyoming, USA. Land Reclamation in Ecological Fragile Areas. , CRC Press. Boca Raton, FL. 251-254 (2017).

- Stohlgren, T. J., Bull, K. A., Otsuki, Y. Comparison of rangeland vegetation sampling techniques in the central grasslands. Journal of Range Management. 51, 164-172 (1998).

- Lovett, G. M., et al. Who needs environmental monitoring. Frontiers in Ecology and the Environment. 5, 253-260 (2007).

- Cagney, J., Cox, S. E., Booth, D. T. Comparison of point intercept and image analysis for monitoring rangeland transects. Rangeland Ecology & Management. 64, 309-315 (2011).

- Toevs, G. R., et al. Consistent indicators and methods and a scalable sample design to meet assessment, inventory, and monitoring needs across scales. Rangelands. 33, 14-20 (2011).

- Stiver, S. J., et al. Sage-grouse habitat assessment framework: multiscale habitat assessment tool. Bureau of Land Management and Western Association of Fish and Wildlife Agencies Technical Reference. , (2015).

- West, N. E. Accounting for rangeland resources over entire landscapes. Proceedings of the VI Rangeland Congress. , Aitkenvale, Queensland, Australia. (1999).

- Curran, M. F., Stahl, P. D. Database management for large scale reclamation projects in Wyoming: Developing better data acquisition, monitoring, and models for application to future projects. Journal of Environmental Solutions for Oil, Gas, and Mining. 1, 31-34 (2015).

- International Technology Team (ITT). Sampling vegetation attributes. Interagency Technical Report. , Denver, CO, USA. (1999).

- Daubenmire, R. F. A canopy-coverage method of vegetational analysis. Northwest Science. 33, 43-64 (1959).

- Heady, H. F., Gibbens, R. P., Powell, R. W. Comparison of charting, line intercept, and line point methods of sampling shrub types of vegetation. Journal of Range Management. 12, 180-188 (1959).

- Levy, E. B., Madden, E. A. The point method of pasture analysis. New Zealand Journal of Agriculture. 46, 267-269 (1933).

- Morrison, L. W. Observer error in vegetation surveys: a review. Journal of Plant Ecology. 9, 367-379 (2016).

- Kennedy, K. A., Addison, P. A. Some considerations for the use of visual estimates of plant cover in biomonitoring. Journal of Ecology. 75, 151-157 (1987).

- Bergstedt, J., Westerberg, L., Milberg, P. In the eye of the beholder: bias and stochastic variation in cover estimates. Plant Ecology. 204, 271-283 (2009).

- Curran, M. F., et al. Spatially balanced sampling and ground-level imagery for vegetation monitoring on reclaimed well pads. Restoration Ecology. 27, 974-980 (2019).

- Duniway, M. C., Karl, J. W., Shrader, S., Baquera, N., Herrick, J. E. Rangeland and pasture monitoring: an approach to interpretation of high-resolution imagery focused on observer calibration for repeatability. Environmental Monitoring and Assessment. 184, 3789-3804 (2011).

- Curran, M. F., et al. Combining spatially balanced sampling, route optimization, and remote sensing to assess biodiversity response to reclamation practices on semi-arid well pads. Biodiversity. , (2020).

- Stevens, D. L., Olsen, A. R. Spatially balanced sampling of natural resources. Journal of the American Statistical Association. 99, 262-278 (2004).

- Robertson, B. L., Brown, J. A., McDonald, T., Jaksons, P. BAS: Balanced acceptance sampling of natural resources. Biometrics. 69, 776-784 (2013).

- Brown, J. A., Robertson, B. L., McDonald, T. Spatially balanced sampling: application to environmental surveys. Procedia Environmental Sciences. 27, 6-9 (2015).

- Robertson, B. L., McDonald, T., Price, C. J., Brown, J. A. A modification of balanced acceptance sampling. Statistics & Probability Letters. 109, 107-112 (2017).

- Kermorvant, C., D'Amico, F., Bru, N., Caill-Milly, N., Robertson, B. Spatially balanced sampling designs for environmental surveys. Environmental Monitoring and Assessment. 191, 524(2019).

- Robertson, B. L., McDonald, T., Price, C. J., Brown, J. A. Halton iterative partitioning: spatially balanced sampling via partitioning. Environmental and Ecological Statistics. 25, 305-323 (2018).

- Hahsler, M., Hornik, K. TSP: Traveling Salesperson Problem (TSP). R package version 1.1-7. , Available from: https://CRAN.R-project.org/package=TSP (2019).

- Booth, D. T., Cox, S. E., Berryman, R. D. Point sampling imagery with 'SamplePoint'. Environmental Monitoring and Assessment. 123, 97-108 (2006).

- Bivand, R., Keitt, T., Rowlingson, B. rgdal: bindings for geospatial data abstraction library. R package version 1.2-7. , Available from: https://CRAN.R-project.org/package=rgdal (2017).

- McDonald, T. SDraw: spatially balanced sample draws for spatial objects. R package version 2.1.3. , Available from: https://CRAN.R-project.org/package=SDraw (2016).

- Ancin-Murguzur, F. J., Munoz, L., Monz, C., Fauchald, P., Hausner, V. Efficient sampling for ecosystem service supply assessment at a landscape scale. Ecosystems and People. 15, 33-41 (2019).

- Pilliod, D. S., Arkle, R. S. Performance of quantitative vegetation sampling methods across gradients of cover in Great Basin plant communities. Rangeland Ecology & Management. 66, 634-637 (2013).

- Anderson, K., Gaston, K. J. Lightweight unmanned aerial vehicles will revolutionize spatial ecology. Frontiers in Ecology and the Environment. 11, 138-146 (2013).

- Barnas, A. F., Darby, B. J., Vandeberg, G. S., Rockwell, R. F., Ellis-Felege, S. N. A comparison of drone imagery and ground-based methods for estimating the extent of habitat destruction by lesser snow geese (Anser caerulescens caerulescens) in La Perouse Bay. PLoS One. 14 (8), 0217049(2019).

- Chabot, D., Carignan, V., Bird, D. M. Measuring habitat quality for leaster bitterns in a created wetland with use of small unmanned aircraft. Wetlands. 34, 527-533 (2014).

- Cruzan, M. B., et al. Small unmanned vehicles (micro-UAVs, drones) in plant ecology. Applications in Plant Sciences. 4 (9), 1600041(2016).

- Booth, D. T., Cox, S. E. Image-based monitoring to measure ecological change in rangeland. Frontiers in Ecology and the Environment. 6, 185-190 (2008).

- Crimmins, M. A., Crimmins, T. M. Monitoring plant phenology using digital repeat photography. Environmental Management. 41, 949-958 (2008).

- Kermorvant, C., et al. Optimization of a survey using spatially balanced sampling: a single-year application of clam monitoring in the Arcachon Bay (SW France). Aquatic Living Resources. 30, 37-48 (2017).

- Brus, D. J. Balanced sampling: a versatile approach for statistical soil surveys. Geoderma. 253, 111-121 (2015).

- Foster, S. D., Hosack, G. R., Hill, N. A., Barnett, N. S., Lucieer, V. L. Choosing between strategies for designing surveys: autonomous underwater vehicles. Methods in Ecology and Evolution. 5, 287-297 (2014).

Access restricted. Please log in or start a trial to view this content.

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenWeitere Artikel entdecken

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten