Un abonnement à JoVE est nécessaire pour voir ce contenu. Connectez-vous ou commencez votre essai gratuit.

Method Article

Imagerie du système aérien sans pilote au niveau du sol associée à un échantillonnage spatialement équilibré et à l’optimisation des itinéraires pour surveiller la végétation des pâturages

Dans cet article

Résumé

Le protocole présenté dans cet article utilise l’optimisation des itinéraires, l’échantillonnage d’acceptation équilibré et l’imagerie au sol et des systèmes d’aéronefs sans pilote (UAS) pour surveiller efficacement la végétation dans les écosystèmes des pâturages. Les résultats des images obtenues à partir de méthodes au sol et UAS sont comparés.

Résumé

Les écosystèmes des pâturages couvrent 3,6 milliards d’hectares dans le monde, dont 239 millions d’hectares aux États-Unis. Ces écosystèmes sont essentiels au maintien des services écosystémiques mondiaux. La surveillance de la végétation dans ces écosystèmes est nécessaire pour évaluer la santé des parcours, pour évaluer la qualité de l’habitat pour la faune et le bétail domestique, pour lutter contre les mauvaises herbes envahissantes et pour élucider les changements environnementaux temporels. Bien que les écosystèmes des pâturages couvrent de vastes superficies, les techniques de surveillance traditionnelles sont souvent longues et peu rentables, sujettes à un biais élevé de l’observateur et manquent souvent d’informations spatiales adéquates. La surveillance de la végétation par l’image est plus rapide, produit des enregistrements permanents (c.-à-d. des images), peut réduire le biais de l’observateur et comprend intrinsèquement des informations spatiales adéquates. Des plans d’échantillonnage spatialement équilibrés sont bénéfiques pour la surveillance des ressources naturelles. Un protocole est présenté pour la mise en œuvre d’un plan d’échantillonnage spatialement équilibré connu sous le nom d’échantillonnage d’acceptation équilibrée (BAS), avec des images acquises à partir de caméras au sol et de systèmes aériens sans pilote (UAS). Un algorithme d’optimisation d’itinéraire est utilisé en plus pour résoudre le « problème du voyageur de commerce » (TSP) afin d’augmenter le temps et la rentabilité. Bien que les images UAS puissent être acquises 2 à 3 fois plus rapidement que les images à main levée, les deux types d’images sont similaires en termes d’exactitude et de précision. Enfin, les avantages et les inconvénients de chaque méthode sont discutés et des exemples d’applications potentielles de ces méthodes dans d’autres écosystèmes sont fournis.

Introduction

Les écosystèmes des pâturages englobent de vastes superficies, couvrant 239 millions d’hectares aux États-Unis et 3,6 milliards d’hectares dans le monde1. Les parcours fournissent un large éventail de services écosystémiques et la gestion des parcours implique de multiples utilisations des terres. Dans l’ouest des États-Unis, les pâturages fournissent un habitat à la faune, au stockage de l’eau, à la séquestration du carbone et au fourrage pour le bétail domestique2. Les parcours naturels sont soumis à diverses perturbations, notamment des espèces envahissantes, des feux de forêt, le développement d’infrastructures et l’extraction de ressources naturelles (p. ex. pétrole, gaz et charbon)3. La surveillance de la végétation est essentielle au maintien de la gestion des ressources dans les pâturages et d’autres écosystèmes du mondeentier 4,5,6. La surveillance de la végétation dans les parcours naturels est souvent utilisée pour évaluer la santé des parcours, la qualité de l’habitat pour les espèces sauvages et pour cataloguer les changements dans les paysages dus aux espèces envahissantes, aux feux de forêt et à l’extraction des ressources naturelles 7,8,9,10. Bien que les objectifs de programmes de surveillance spécifiques puissent varier, des programmes de surveillance qui répondent aux besoins de plusieurs intervenants tout en étant statistiquement fiables, reproductibles et économiques sont souhaités 5,7,11. Bien que les gestionnaires des terres reconnaissent l’importance de la surveillance, celle-ci est souvent considérée comme non scientifique, non économique et lourde5.

Traditionnellement, la surveillance des parcours a été effectuée à l’aide de diverses méthodes, notamment l’estimation oculaire ou visuelle10, les cadres de Daubenmire12, la cartographie de parcelle13 et l’interception de points linéaires le long des transects de végétation14. Bien que l’estimation oculaire ou visuelle soit efficace en termes de temps, elle est sujette à un biais d’observateur élevé15. D’autres méthodes traditionnelles, bien qu’elles soient également sujettes à un biais élevé de l’observateur, sont souvent inefficaces en raison de leur temps et de leur coût 6,15,16,17. Le temps nécessaire à la mise en œuvre d’un grand nombre de ces méthodes traditionnelles est souvent trop lourd, ce qui rend difficile l’obtention de tailles d’échantillon statistiquement valides, ce qui entraîne des estimations de population peu fiables. Ces méthodes sont souvent appliquées pour des raisons de commodité plutôt que de manière stochastique, les observateurs choisissant l’endroit où ils collectent les données. De plus, les emplacements des échantillons rapportés et réels diffèrent fréquemment, ce qui crée de la confusion pour les gestionnaires des terres et les autres parties prenantes qui dépendent des données de surveillance de la végétation18. Des recherches récentes ont démontré que la surveillance de la végétation basée sur l’image est efficace en termes de temps et de coûts 6,19,20. L’augmentation de la quantité de données pouvant être échantillonnées dans une zone donnée en peu de temps devrait améliorer la fiabilité statistique des données par rapport aux techniques traditionnelles plus chronophages. Les images sont des enregistrements permanents qui peuvent être analysés par plusieurs observateurs après la collecte des données de terrain6. De plus, de nombreux appareils photo sont équipés de systèmes de positionnement global (GPS), de sorte que les images peuvent être géolocalisées avec un emplacement de collecte18,20. L’utilisation de points d’échantillonnage générés par ordinateur, situés avec précision sur le terrain, devrait réduire le biais de l’observateur, que l’image soit acquise avec une caméra portative ou par un système aérien sans pilote, car elle réduit la propension d’un observateur individuel à utiliser son opinion sur l’endroit où les emplacements des échantillons devraient être placés.

En plus d’être longue, coûteuse et sujette à un biais élevé de l’observateur, la surveillance traditionnelle des ressources naturelles ne parvient souvent pas à caractériser correctement les parcours hétérogènes en raison de la faible taille de l’échantillon et des lieux d’échantillonnage concentrés21. Les plans d’échantillonnage spatialement équilibrés répartissent les emplacements d’échantillonnage plus uniformément dans une zone d’intérêt afin de mieux caractériser les ressources naturelles 21,22,23,24. Ces plans peuvent réduire les coûts d’échantillonnage, car des échantillons de plus petite taille sont nécessaires pour obtenir une précision statistique par rapport à l’échantillonnage aléatoire simple25.

Dans cette méthode, un plan d’échantillonnage spatialement équilibré connu sous le nom d’échantillonnage à acceptation équilibrée (BAS)22,24 est combiné à une surveillance basée sur l’image pour évaluer la végétation des parcours. Les points BAS sont répartis de manière optimale sur la zone d’intérêt26. Cependant, cela ne garantit pas que les points seront commandés dans un itinéraire optimal pour la visite20. Par conséquent, les points BAS sont disposés à l’aide d’un algorithme d’optimisation d’itinéraire qui résout le problème du voyageur de commerce (TSP)27. La visite des points dans cet ordre détermine un chemin optimal (c’est-à-dire la distance minimale) reliant les points. Les points BAS sont transférés dans un logiciel de système d’information géographique (SIG), puis dans une unité de collecte de données portable équipée d’un GPS. Une fois les points BAS localisés, les images sont prises à l’aide d’une caméra équipée d’un GPS ainsi que d’un système aérien sans pilote exploité à l’aide d’un logiciel de vol. Une fois sur le terrain, un technicien se rend à chaque point pour acquérir des images de caméra monopode de1 m 2 avec une distance d’échantillonnage au sol (GSD) de 0,3 mm à chaque point BAS, tandis qu’un UAS vole vers les mêmes points et acquiert des images GSD de 2,4 mm. Par la suite, les données sur la couverture végétale sont générées à l’aide de « SamplePoint »28 pour classer manuellement 36 points/image. Les données sur la couverture végétale générées à partir de l’analyse des images au sol et des drones sont comparées, ainsi que les temps d’acquisition rapportés pour chaque méthode. Dans l’étude représentative, deux parcelles de parcours adjacentes de 10 acres ont été utilisées. Enfin, d’autres applications de cette méthode et la façon dont elle peut être modifiée pour de futurs projets ou des projets dans d’autres écosystèmes sont discutées.

Protocole

1. Définition de la zone d’étude, génération des points d’échantillonnage et du chemin de déplacement, et préparation du terrain

- Définition du domaine d’études

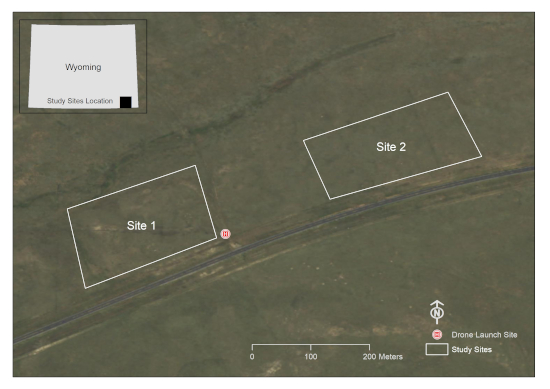

- Utilisez un logiciel SIG pour dessiner un ou plusieurs graphiques polygonaux autour de la ou des zones d’intérêt. Cette étude a été menée sur deux parcelles de 10 acres dans un lotissement de pâturage dans le comté de Laramie, WY, États-Unis (figure 1).

- S’assurer que les zones qui ne sont pas censées être à l’intérieur de la base de sondage sont exclues du polygone (p. ex., plans d’eau, structures de bâtiments, routes, etc.). Cela garantira que des images de ces zones ne seront pas prises plus tard.

- Convertissez le graphique polygonal en fonction de fichier de forme (.shp) dans le logiciel SIG et assurez-vous que le fichier de forme est créé dans le système de coordonnées souhaité.

Figure 1 : Représentation des zones d’étude d’intérêt. Cet emplacement se trouve sur un lotissement de pâturage au sud de Cheyenne, dans le comté de Laramie, dans le WY, aux États-Unis (Source de l’imagerie : Wyoming NAIP Imagery 2017). Veuillez cliquer ici pour voir une version agrandie de cette figure.

- Génération des points BAS et optimisation de la trajectoire de déplacement

REMARQUE : Le code est joint comme 'Supplemental_Code.docx'.- Utilisez le package R 'rgdal'29 pour convertir le polygone SIG en un fichier lisible par le programme R.

- Utilisez le package R 'SDraw'30 pour générer le nombre souhaité de points BAS. Cette étude a utilisé 30 points BAS par zone d’étude, mais des recherches futures devraient être menées pour déterminer l’intensité d’échantillonnage optimale pour des zones de tailles et de compositions végétales variées.

- Utilisez le package R 'TSP'27 pour commander les points BAS. La visite des points dans cet ordre minimise le temps nécessaire pour obtenir des échantillons aux points BAS.

- Préparation à l’acquisition d’images à main levée

- Utilisez le package R 'rgdal' pour transférer les points de l’étape 1.2.1 dans le programme SIG.

- Modifiez la table attributaire du fichier de formes afin que le champ ID de point reflète précisément l’ordre de chemin optimisé.

- Transférez le polygone SIG et le fichier de points dans le logiciel SIG fonctionnant sur une unité portable.

- Assurez-vous que le système de coordonnées projetées correct pour la zone d’intérêt est en place.

- Préparation à l’acquisition d’images UAS

- Utilisez le package R 'rgdal' pour transférer les points de l’étape 1.2.1 dans le logiciel SIG.

- Dans le logiciel SIG, utilisez l’outil Ajouter des coordonnées XY pour créer et renseigner des champs de latitude et de longitude dans la table attributaire de points de cheminement.

- Exportez la table d’attributs de waypoint contenant les colonnes Latitude, Longitude et TSP au format de fichier *.csv.

- Ouvrez le fichier *.csv dans un progiciel approprié.

- Triez les points de cheminement par identifiant TSP.

- Ouvrez l’application Mission Hub.

- Créez un waypoint arbitraire dans Mission Hub.

- Exportez un point de cheminement arbitraire sous forme de fichier *.csv.

- Ouvrez le fichier *.csv dans un tableur et supprimez les points de cheminement arbitraires en conservant les en-têtes de colonne.

- Copiez les paires de coordonnées de waypoint triées TSP de l’étape 1.2.3 dans les colonnes appropriées du fichier *.csv de l’étape 1.4.8.

- Importez le fichier *.csv de l’étape 1.4.10 dans Mission Hub en tant que nouvelle mission.

- Définissez les paramètres.

- Cochez la case Utiliser l’élévation en ligne .

- Spécifiez le mode de tracé sous forme de lignes droites.

- Spécifiez l’action de fin sur RTH pour permettre au drone de revenir à la maison une fois la mission terminée.

- Cliquez sur des points de cheminement individuels et ajoutez des actions en spécifiant les paramètres suivants : Séjour : 2 s (pour éviter le flou de l’image) ; Caméra inclinable : -90° (Nadir) ; Prenez une photo.

- Enregistrez la mission avec un nom approprié.

- Répétez le processus pour d’autres sites.

2. Collecte et post-traitement des données sur le terrain

- Enregistrement de la végétation observée ou attendue dans la zone d’étude

- Avant d’acquérir des images, créez une liste de la végétation observée dans la zone d’étude. Cela peut se faire sur une feuille manuscrite ou sur un formulaire numérique pour faciliter l’identification avec photo plus tard. Il peut être avantageux d’inclure dans l’inventaire les espèces qui sont susceptibles d’être observées dans la zone même si elles ne sont pas observées sur le terrain (p. ex., les espèces dans les mélanges de semences de récupération)18.

- Acquisition d’images au sol

- Fixez un appareil photo à un monopode vertical et pointez l’appareil photo vers le bas à environ 60°. La zone de l’image peut être déterminée à l’aide des spécifications de l’objectif et de la résolution (mégapixels) de l’appareil photo et du réglage du monopode à une hauteur standard. La hauteur du monopode couplée aux spécifications de la caméra déterminera la distance d’échantillonnage au sol (GSD). Dans cette étude, une caméra de 12,1 mégapixels a été utilisée et le monopode a été réglé à une position constante de 1,3 m au-dessus du sol pour obtenir des images Nadir à ~0,3 mm GSD18.

- Inclinez le monopode vers l’avant de sorte que l’objectif de l’appareil photo soit en position Nadir et que le monopode incliné ne soit pas visible dans l’image.

- Ajustez la hauteur du monopode ou du zoom de l’objectif pour obtenir une taille de parcelle sans cadre de 1 m2 (ou une autre taille de parcelle souhaitée). Pour les caméras au format 4:3 les plus courantes, une largeur de tracé de 115 cm donne un champ de vision d’image de 1 m2 . Il n’est pas nécessaire de poser un cadre sur le sol ; L’image entière est l’intrigue. Si vous ajustez le zoom de l’objectif pour ce faire, utilisez du ruban adhésif pour éviter toute modification accidentelle du réglage du zoom.

- Si possible, réglez l’appareil photo en mode priorité à la vitesse et réglez la vitesse d’obturation sur au moins 1/125 s pour éviter le flou dans l’image ; plus rapide s’il y a du vent.

- Localisez le premier point dans l’ordre de chemin optimisé.

- Placez le monopode sur le sol au point 1 et inclinez-le jusqu’à ce que l’appareil photo soit en orientation Nadir. Assurez-vous que l’ombre de l’opérateur n’est pas dans l’image. Maintenez l’appareil photo stable pour éviter le flou de mouvement. Acquérez l’image.

REMARQUE : Un câble de déclenchement à distance est utile pour cette étape. - Vérifiez la qualité de l’image pour garantir une capture de données réussie.

- Naviguez jusqu’au point suivant dans l’ordre de chemin optimisé et répétez les étapes d’acquisition.

- Acquisition d’images par drone

- Avant de lancer l’UAS, effectuez une brève reconnaissance de la zone d’étude pour s’assurer qu’aucun obstacle physique ne se trouve sur la trajectoire de vol. Cet exercice de reconnaissance est également utile pour localiser une zone assez plate à partir de laquelle lancer l’UAS.

- Assurez-vous que les conditions météorologiques sont propices au vol de l’UAS : une journée sèche et dégagée (visibilité de >4,8 km) avec un éclairage adéquat, un vent minimal (<17 nœuds) et des températures comprises entre 0 °C et 37 °C.

- Respectez les protocoles légaux. Par exemple, aux États-Unis, les politiques de la Federal Aviation Administration devraient être suivies.

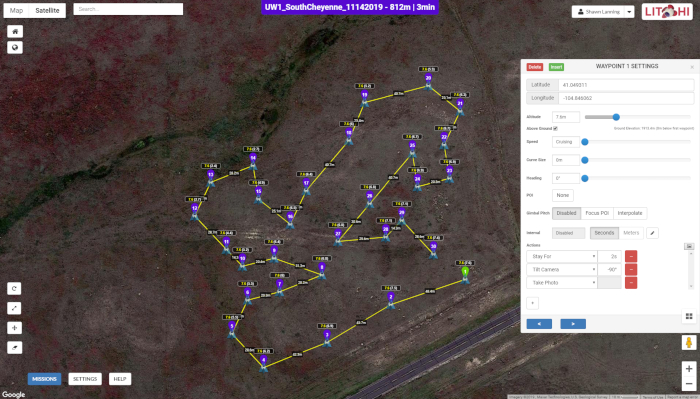

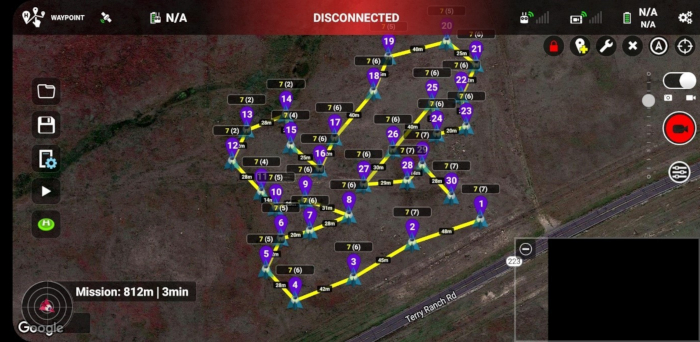

- Utilisez le logiciel Mission Hub (Figure 2) et une application d’exécution de mission accessible via des appareils mobiles (Figure 3).

- Recueillir des images UAS à chaque point BAS comme décrit à l’étape 1.4.

- Vérifiez que toutes les images ont été acquises à l’aide de l’appareil mobile avant de changer d’emplacement.

Figure 2 : Interface utilisateur de Mission Hub. La carte représente la trajectoire de vol du drone le long d’une série de 30 points BAS sur l’un des sites d’étude, tandis que la fenêtre contextuelle affiche les paramètres d’acquisition d’images à chaque point de cheminement. La figure 2 est spécifique au site 1, bien qu’elle soit similaire en apparence au site 2. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Figure 3 : La mission de vol de waypoint dans l’application d’exécution de mission de Litchi fonctionnant sur un smartphone Android. Les identifiants uniques des points de cheminement sont indiqués en violet et représentent l’ordre relatif dans lequel les images ont été prises à différents points de la zone d’étude. Les chiffres à chaque point de cheminement, tels que 7(6), indiquent les valeurs entières des hauteurs au-dessus du sol auxquelles les images ont été prises (premier chiffre) et des hauteurs au-dessus du point d’origine ou du site de lancement du drone (deuxième chiffre). Notez les distances entre les points de cheminement successifs qui sont étiquetés sur la carte. La figure 3 est spécifique au site 1, bien qu’elle soit similaire en apparence au site 2. Veuillez cliquer ici pour voir une version agrandie de cette figure.

- Post-traitement d’images au niveau du sol.

REMARQUE : Les instructions sont disponibles à www.SamplePoint.org dans la section tutoriel ; Un dossier de .pdf supplémentaire est joint au présent document.- Téléchargez des images sur un ordinateur avec un câble USB ou une carte SD.

- Assurez-vous que les images ont été prises aux bons endroits. Il existe divers logiciels pour placer des images dans le logiciel SIG en fonction des métadonnées des images géolocalisées.

- Si les images ont été acquises dans plusieurs zones d’étude, stockez-les dans des dossiers séparés pour l’analyse des images.

- Post-traitement d’images UAS

- Transférez les images enregistrées sur une carte microSD amovible de l’UAS vers l’ordinateur.

- Répétez les étapes 2.4.2 et 2.4.3.

3. Analyse d’images

REMARQUE : Toutes les étapes se trouvent dans la section 'tutoriel' sur www.SamplePoint.org ; Un fichier supplémentaire tutorial.pdf est joint en pièce jointe.

- Dans SamplePoint, cliquez sur Options | Assistant de base de données | Créer/remplir une base de données.

- Nommez la base de données en fonction de la zone d’étude.

- Naviguez jusqu’au dossier contenant les échantillons de la zone d’étude souhaités et sélectionnez ceux à classer.

- Cliquez sur OK.

- Cliquez sur Options | Sélectionnez Base de données et sélectionnez le fichier *.xls généré par SamplePoint en fonction de la sélection d’image (ce sera dans l’image).

- Vérifiez que le nombre correct d’images a été sélectionné dans la base de données à l’invite de SamplePoint.

- Sélectionnez le nombre de pixels à analyser dans chaque image. Cela peut être fait selon un modèle de grille ou de manière aléatoire. Cette étude a utilisé une grille de 6 x 6 pour sélectionner un total de 36 pixels, bien que plus ou moins de pixels par image puissent être classés en fonction de la précision de mesure souhaitée pour la classification. Une étude récente a révélé que 20 à 30 pixels par image sont suffisants pour échantillonner de grandes surfaces31. L’option grid garantit que les pixels seront au même endroit si l’image est réanalysée, tandis que l’option random générera des pixels de manière aléatoire chaque fois qu’une image est rechargée.

- Créez un fichier Button personnalisé pour la classification des espèces. Cette liste peut être générée à partir de la liste de végétation enregistrée sur le terrain avant l’acquisition de l’image, ou elle peut être basée sur d’autres renseignements pertinents à la zone d’étude (p. ex., liste des mélanges de semences sur les sites remis en état, ou renseignements sur la description écologique du site, etc.). Assurez-vous qu’un bouton est créé pour le sol nu ou le sol et d’autres éléments non végétaux potentiels qui peuvent être rencontrés, tels que la litière ou la roche. La création d’un bouton Inconnu est recommandée pour permettre à l’analyste de classer les espèces à une date ultérieure. La zone de commentaire de SamplePoint peut être utilisée pour noter les pixels qui ont utilisé cette option. De plus, si la résolution de l’image n’est pas assez élevée pour être classée au niveau de l’espèce, il est avantageux de créer des boutons pour des groupes fonctionnels (p. ex., herbe, plante herbacée non graminoïde, arbuste).

- Commencez l’analyse des images en cliquant sur le bouton de classification qui décrit le pixel de l’image ciblé par le réticule rouge. Répétez cette opération jusqu’à ce que SamplePoint vous demande « C’est-à-dire tous les points. Cliquez sur l’image suivante. Répétez cette opération pour toutes les images de la base de données.

REMARQUE : La fonction Zoom peut être utilisée pour faciliter la classification. - Lorsque toutes les images de la base de données sont complètement analysées, SamplePoint vous demande « Vous avez épuisé toutes les images ». À ce stade, sélectionnez OK , puis cliquez sur Options | Créez des fichiers de statistiques.

- Allez dans le dossier contenant la base de données et ouvrez le fichier *.csv qui vient d’être créé pour vous assurer que les données de toutes les images sont stockées.

4. Analyse statistique

- Analyses du khi-deux pour déterminer les différences entre les sites

- Étant donné que le même nombre d’images (unités d’échantillonnage primaires) et de pixels (unités d’échantillonnage secondaires) sont collectés et analysés aux deux sites, la comparaison entre les deux sites peut être considérée comme un produit de la conception multinomiale.

- À l’aide du fichier *.csv créé à l’étape 3.11, calculez la somme des points classés pour chaque catégorie de classification.

- Effectuez une analyse du khi-deux sur les sommes de points. Si le site 1 et le site 2 sont similaires, un nombre à peu près égal de pixels classés pour chaque type de couverture sera évident sur les deux sites18.

- Régression pour comparer les images UAS et les images au niveau du sol

- À l’aide des fichiers *.csv créés à l’étape 3.11, copiez et collez le pourcentage moyen de couverture de chaque image et alignez les données d’image UAS sur les données d’image au niveau du sol.

- Effectuer une analyse de régression dans un programme de base de données.

Résultats

L’acquisition d’images par drone a pris moins de la moitié du temps de la collecte d’images au sol, alors que le temps d’analyse était légèrement inférieur avec les images au sol (tableau 1). Les images au sol avaient une résolution plus élevée, ce qui explique probablement pourquoi elles ont été analysées en moins de temps. Les différences dans les temps de parcours pédestres entre les sites étaient probablement dues au fait que les points de dépa...

Discussion

L’importance de la surveillance des ressources naturelles est reconnue depuis longtemps14. Compte tenu de l’attention accrue portée aux problèmes environnementaux mondiaux, il est de plus en plus important de mettre au point des techniques de surveillance fiables, efficaces en termes de temps et d’argent. Plusieurs études antérieures ont montré que l’analyse d’images se compare favorablement aux techniques traditionnelles de surveillance de la vég?...

Déclarations de divulgation

Les auteurs ne déclarent aucun conflit d’intérêts. Le logiciel utilisé dans cette étude était à la disposition des auteurs, soit en open source, soit par le biais d’autorisations institutionnelles. Aucun auteur n’est parrainé par un logiciel utilisé dans cette étude et reconnaît qu’il existe d’autres logiciels capables d’effectuer des recherches similaires.

Remerciements

Cette recherche a été financée en majorité par le Wyoming Reclamation and Restoration Center et Jonah Energy, LLC. Nous remercions Warren Resources et Escelara Resources d’avoir financé l’unité Trimble Juno 5. Nous remercions Jonah Energy, LLC pour son soutien continu au financement de la surveillance de la végétation dans le Wyoming. Nous remercions le Wyoming Geographic Information Science Center d’avoir fourni l’équipement UAS utilisé dans cette étude.

matériels

| Name | Company | Catalog Number | Comments |

| ArcGIS | ESRI | GPS Software | |

| DJI Phantom 4 Pro | DJI | UAS | |

| G700SE | Ricoh | GPS-equipped camera | |

| GeoJot+Core | Geospatial Experts | GPS Software | Used to extract image metadata |

| Juno 5 | Trimble | Handheld GPS device | |

| Litchi Mission Hub | Litchi | Mission Hub Software | We chose Litchi for its terrain awareness and its ability to plan robust waypoint missions |

| Program R | R Project | Statistical analysis/programming software | |

| SamplePoint | N/A | Image analysis software |

Références

- Follett, R. F., Reed, D. A. Soil carbon sequestration in grazing lands: societal benefits and policy implications. Rangeland Ecology & Management. 63, 4-15 (2010).

- Ritten, J. P., Bastian, C. T., Rashford, B. S. Profitability of carbon sequestration in western rangelands of the United States. Rangeland Ecology & Management. 65, 340-350 (2012).

- Stahl, P. D., Curran, M. F. Collaborative efforts towards ecological habitat restoration of a threatened species, Greater Sage-grouse, in Wyoming, USA. Land Reclamation in Ecological Fragile Areas. , 251-254 (2017).

- Stohlgren, T. J., Bull, K. A., Otsuki, Y. Comparison of rangeland vegetation sampling techniques in the central grasslands. Journal of Range Management. 51, 164-172 (1998).

- Lovett, G. M., et al. Who needs environmental monitoring. Frontiers in Ecology and the Environment. 5, 253-260 (2007).

- Cagney, J., Cox, S. E., Booth, D. T. Comparison of point intercept and image analysis for monitoring rangeland transects. Rangeland Ecology & Management. 64, 309-315 (2011).

- Toevs, G. R., et al. Consistent indicators and methods and a scalable sample design to meet assessment, inventory, and monitoring needs across scales. Rangelands. 33, 14-20 (2011).

- Stiver, S. J., et al. Sage-grouse habitat assessment framework: multiscale habitat assessment tool. Bureau of Land Management and Western Association of Fish and Wildlife Agencies Technical Reference. , (2015).

- West, N. E. Accounting for rangeland resources over entire landscapes. Proceedings of the VI Rangeland Congress. , (1999).

- Curran, M. F., Stahl, P. D. Database management for large scale reclamation projects in Wyoming: Developing better data acquisition, monitoring, and models for application to future projects. Journal of Environmental Solutions for Oil, Gas, and Mining. 1, 31-34 (2015).

- International Technology Team (ITT). Sampling vegetation attributes. Interagency Technical Report. , (1999).

- Daubenmire, R. F. A canopy-coverage method of vegetational analysis. Northwest Science. 33, 43-64 (1959).

- Heady, H. F., Gibbens, R. P., Powell, R. W. Comparison of charting, line intercept, and line point methods of sampling shrub types of vegetation. Journal of Range Management. 12, 180-188 (1959).

- Levy, E. B., Madden, E. A. The point method of pasture analysis. New Zealand Journal of Agriculture. 46, 267-269 (1933).

- Morrison, L. W. Observer error in vegetation surveys: a review. Journal of Plant Ecology. 9, 367-379 (2016).

- Kennedy, K. A., Addison, P. A. Some considerations for the use of visual estimates of plant cover in biomonitoring. Journal of Ecology. 75, 151-157 (1987).

- Bergstedt, J., Westerberg, L., Milberg, P. In the eye of the beholder: bias and stochastic variation in cover estimates. Plant Ecology. 204, 271-283 (2009).

- Curran, M. F., et al. Spatially balanced sampling and ground-level imagery for vegetation monitoring on reclaimed well pads. Restoration Ecology. 27, 974-980 (2019).

- Duniway, M. C., Karl, J. W., Shrader, S., Baquera, N., Herrick, J. E. Rangeland and pasture monitoring: an approach to interpretation of high-resolution imagery focused on observer calibration for repeatability. Environmental Monitoring and Assessment. 184, 3789-3804 (2011).

- Curran, M. F., et al. Combining spatially balanced sampling, route optimization, and remote sensing to assess biodiversity response to reclamation practices on semi-arid well pads. Biodiversity. , (2020).

- Stevens, D. L., Olsen, A. R. Spatially balanced sampling of natural resources. Journal of the American Statistical Association. 99, 262-278 (2004).

- Robertson, B. L., Brown, J. A., McDonald, T., Jaksons, P. BAS: Balanced acceptance sampling of natural resources. Biometrics. 69, 776-784 (2013).

- Brown, J. A., Robertson, B. L., McDonald, T. Spatially balanced sampling: application to environmental surveys. Procedia Environmental Sciences. 27, 6-9 (2015).

- Robertson, B. L., McDonald, T., Price, C. J., Brown, J. A. A modification of balanced acceptance sampling. Statistics & Probability Letters. 109, 107-112 (2017).

- Kermorvant, C., D'Amico, F., Bru, N., Caill-Milly, N., Robertson, B. Spatially balanced sampling designs for environmental surveys. Environmental Monitoring and Assessment. 191, 524 (2019).

- Robertson, B. L., McDonald, T., Price, C. J., Brown, J. A. Halton iterative partitioning: spatially balanced sampling via partitioning. Environmental and Ecological Statistics. 25, 305-323 (2018).

- TSP: Traveling Salesperson Problem (TSP). R package version 1.1-7 Available from: https://CRAN.R-project.org/package=TSP (2019)

- Booth, D. T., Cox, S. E., Berryman, R. D. Point sampling imagery with 'SamplePoint'. Environmental Monitoring and Assessment. 123, 97-108 (2006).

- rgdal: bindings for geospatial data abstraction library. R package version 1.2-7 Available from: https://CRAN.R-project.org/package=rgdal (2017)

- SDraw: spatially balanced sample draws for spatial objects. R package version 2.1.3 Available from: https://CRAN.R-project.org/package=SDraw (2016)

- Ancin-Murguzur, F. J., Munoz, L., Monz, C., Fauchald, P., Hausner, V. Efficient sampling for ecosystem service supply assessment at a landscape scale. Ecosystems and People. 15, 33-41 (2019).

- Pilliod, D. S., Arkle, R. S. Performance of quantitative vegetation sampling methods across gradients of cover in Great Basin plant communities. Rangeland Ecology & Management. 66, 634-637 (2013).

- Anderson, K., Gaston, K. J. Lightweight unmanned aerial vehicles will revolutionize spatial ecology. Frontiers in Ecology and the Environment. 11, 138-146 (2013).

- Barnas, A. F., Darby, B. J., Vandeberg, G. S., Rockwell, R. F., Ellis-Felege, S. N. A comparison of drone imagery and ground-based methods for estimating the extent of habitat destruction by lesser snow geese (Anser caerulescens caerulescens) in La Perouse Bay. PLoS One. 14 (8), 0217049 (2019).

- Chabot, D., Carignan, V., Bird, D. M. Measuring habitat quality for leaster bitterns in a created wetland with use of small unmanned aircraft. Wetlands. 34, 527-533 (2014).

- Cruzan, M. B., et al. Small unmanned vehicles (micro-UAVs, drones) in plant ecology. Applications in Plant Sciences. 4 (9), 1600041 (2016).

- Booth, D. T., Cox, S. E. Image-based monitoring to measure ecological change in rangeland. Frontiers in Ecology and the Environment. 6, 185-190 (2008).

- Crimmins, M. A., Crimmins, T. M. Monitoring plant phenology using digital repeat photography. Environmental Management. 41, 949-958 (2008).

- Kermorvant, C., et al. Optimization of a survey using spatially balanced sampling: a single-year application of clam monitoring in the Arcachon Bay (SW France). Aquatic Living Resources. 30, 37-48 (2017).

- Brus, D. J. Balanced sampling: a versatile approach for statistical soil surveys. Geoderma. 253, 111-121 (2015).

- Foster, S. D., Hosack, G. R., Hill, N. A., Barnett, N. S., Lucieer, V. L. Choosing between strategies for designing surveys: autonomous underwater vehicles. Methods in Ecology and Evolution. 5, 287-297 (2014).

Réimpressions et Autorisations

Demande d’autorisation pour utiliser le texte ou les figures de cet article JoVE

Demande d’autorisationExplorer plus d’articles

This article has been published

Video Coming Soon